【ChatGPT看业界】存储三强加码HBM,谁将胜出?

编者按:作为扎根行业多年的专业ICT产业咨询服务机构,爱集微一直致力于汇聚丰富优质的行业资源和聚焦前沿技术打造中国半导体行业大数据平台,以成为“领先的AIGC行业信息专家”为目标,以“聚焦行业大数据,让决策更科学”为愿景,通过积极导入现代化信息技术手段,助力业务发展以及合作伙伴获得成功。基于此,爱集微推出【ChatGPT看业界】栏目,结合行业中的热点话题及重点事件,通过和ChatGPT的深度“卷入”制作系列文章。

7月26日,SK海力士发布第二季度财务报告,营收7.3059万亿韩元(约57亿美元),营业亏损2.8821万亿韩元,但HBM(高带宽内存)成为一个亮点。SK海力士表示,随着以ChatGPT为中心的生成式AI市场的扩大,HBM3和DDR5 DRAM等高端产品销售增加,第二季度营业收入比第一季度增加44%,营业亏损减少15%。

与此同时,三星和美光也将HBM作为下一步业务增长的关键动力。三星表示将投资1万亿韩元扩大HBM产能。美光预计其“将在 2024 财年贡献有意义的收入,并在 2025 年贡献大幅增加的收入”。在内存市场触底之际,HBM几乎成为存储三强半年来仅有亮点业务。可以预见,接下来三大厂商必将加大对HBM的争夺力度。

AI巨头扩大HBM采购

ChatGPT热潮除将GPU等AI大算力芯片推向高峰之外,也极大带动了市场对新一代内存芯片HBM的需求。7月26日SK海力士发布第二季度财务报告,尽管整体出现亏损,但HBM3和DDR5 DRAM等高端产品销售增加,第二季度营业收入比第一季度增加44%,营业亏损减少15%。三星和美光也表示,HBM在销售额中开始占据更大份额。

事实上,目前全球各大AI巨头包括英伟达、AMD、微软和亚马逊等均已开始加大HBM采购,并将HBM3E作为其采购的重点。这一举措被视为在新一轮AI大战中抢占先机,以应对日益激烈的市场竞争。

英伟达作为全球领先的GPU制造商,其H100、A100已广泛应用于AI服务器和数据中心。在面对AI应用日益增长的挑战下,英伟达加大HBM3E的采购量,旨在为其GPU提供更高性能和更快的数据传输速率,以满足AI计算的需求。

AMD最近发布下一代GPU MI300X。MI300X面向大语言模型(LLM)优化,可以支持400亿个参数的Hugging Face AI 模型运行。在存储方面,MI300X采用192GB的HBM3内存、5.2TB/秒的带宽和896GB/秒的Infinity Fabric 带宽。为了提高其GPU在AI应用中的竞争力,AMD将加大对HBM3E的采购量,以进一步提升其产品的性能和效率。

亚马逊和微软则是云服务领域的两大巨头。在大模型热潮下,两家公司也大幅增加投资,优先引入生成式AI技术。亚马逊近期投资1亿美元建立人工智能创新中心。微软旗下的Azure云服务则扩大与ChatGPT开发商OpenAI的合作关系。

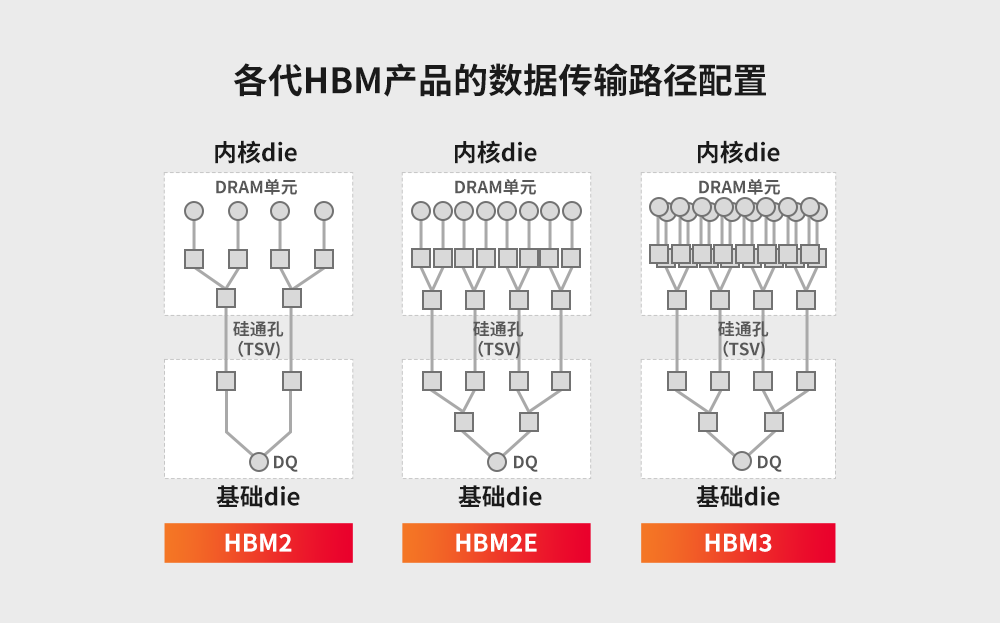

从发布的数据来看,HBM3E与HBM3相比,传输速度提升25%,从原来的6.4GT/s提升至8.0GT/s,从而将显存的带宽提升至1TB/s。SK 海力士将采用最新的10纳米级(1b) 技术进行HBM3E的量产。各大AI巨头积极向HBM供应商SK海力士以及三星订购HBM3E,以满足不断增长的市场需求。

有哪些企业将是HBM的潜在用户?记者查询了ChatGPT。以下为查询结果。

HBM需求迎来爆发式增长

过去,HBM位元需求仅占整体DRAM市场的不到1%,主要受限于高昂的成本以及服务器市场中搭载相关AI运算卡的比例较小。然而,到了今年年初,随着AI服务器需求的爆发,HBM的地位得到了根本性的改变,成为AI服务器的标配。

英伟达H100、A100、A800以及AMD MI250、MI250X系列GPU主要在AI服务器市场占据主导地位,这些高端GPU基本都配备了HBM。HBM的高速、高带宽特性,使得其成为支撑AI服务器算力的必备选择。

集邦咨询称,目前高端AI服务器GPU搭载HBM芯片已成主流,预计2023年全球HBM需求量将年增近六成,达到2.9亿GB,2024年将再增长30%。2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台。HBM成本在AI服务器成本中占比排名第三,约占9%,单机ASP(单机平均售价)高达18000美元。

除了AI服务器之外,HBM还有哪些潜在的应用领域?记者查询了ChatGPT。以下为查询结果。

SK海力士、三星和美光角逐HBM市场

近日,HBM市场迎来了一场竞争高潮,SK海力士、三星,美光展开争夺HBM市场主导地位的角逐。

SK海力士有望成为全球推出首款HBM3E产品的企业。SK海力士还透露了其下一代产品的具体路线图,将第六代HBM产品HBM4的生产目标定为2026年。SK海力士公开表示,将把下一代后处理技术“混合键合(hybrid bonding)”应用于HBM4产品。与现有的“非导电膜”工艺相比,提高散热效率并减少布线长度,从而实现更高的输入/输出密度。这会将当前的最大12层增加到16层。SK海力士在HBM技术方面起步较早,在2014年率先成功研发HBM1,确立了其在行业中的领先地位。此后,SK海力士不断推进技术,2022年成功为英伟达提供HBM3芯片,巩固了自己的市场领先地位。

三星也不甘示弱,计划投资1万亿韩元来扩大HBM的产能。据韩国ET News报道,三星目标是在2024年底将HBM产能翻一番,并已经下了主要设备的订单。三星计划在天安工厂安装新设备,以提高HBM的出货量。考虑到HBM是由多个DRAM垂直连接而成,三星需要增加更多后端工艺设备来实现增产。

在HBM市场竞争中,美光也不容忽视的参与者。美光最新推出8层24GB HBM3 Gen2内存芯片。美光宣称其为HBM3的下一代产品,采用1β工艺节点,总带宽超过1.2TB/s,引脚速度超过9.2Gb/s,比HBM3提高50%。此外,HBM3 Gen2的每瓦性能是HBM3的2.5倍左右,能效大幅提升。目前,美光在HBM市场上的份额约为10%,相较于SK海力士和三星较为薄弱。但美光也在加大研发和投资力度,试图在HBM领域取得更大突破。随着技术的进步和投资的增加,美光有望增强在HBM市场中的竞争力,与SK海力士和三星展开更加激烈的竞争。

从目前全球HBM市场份额来看,SK海力士技术起步早,市场份额约为50%,三星为40%,美光约为10%。预计到2023年,SK海力士的市场份额有望提升至53%,而三星和美光的市场份额分别为38%和9%。

影响各企业在HBM市场竞争中胜出的因素有哪些?记者者查询了ChatGPT。以下为查询结果。

*此内容为集微网原创,著作权归集微网所有,爱集微,爱原创

晶圆产能释放利好,溅射靶材三厂竞速

专利申请

专利申请

知识产权质押融资

知识产权质押融资

专利地图分析

专利地图分析

版权登记

版权登记

集成电路布图设计

集成电路布图设计

商标交易

商标交易

商标申请

商标申请

专利交易

专利交易

专利无效

专利无效

热门评论