(文/张轶群)去年底,由ChatGPT引发的生成式AI浪潮席卷全球。此前任何一次人工智能的变革浪潮,从未像这次一样,让AI技术与消费者个体的距离如此之近。

与AlphaGo等机器战胜人脑所带来的竞争挫败感不同,生成式AI所提供的协同上的成就感,以及带来的广泛的行业变革和巨大机遇,让所有人都兴奋不已。

尽管如此,在如今多数场景下,从云端获得生成式AI体验仍然显得繁琐且昂贵。如何在手机、PC等终端侧实现对于生成式AI、大模型能力的支持成为业界期待。

近期,移动连接,智能边缘计算领军企业高通所进行一系列创新演示,让业界看到,生成式AI实现在终端侧落地的愿景已经近在眼前。

终端侧AI优势显著

有史以来增速最快的消费类应用,2020年-2025年相关投资增长425%的预期,以及1万亿美元的市场规模……生成式AI如同坐上火箭一飞冲天。

但与此同时,由于生成式AI模型的使用量和复杂性在不断增长,动辄千亿参数的大模型叠加上众多应用以及数十亿的用户基数,给云端带来负担也是显著的,仅在云端进行推理并不划算,如何降本也成为行业热议的话题。

以生成式AI搜索为例,相比于传统方式,虽然能够带来更加出色的体验和结果,但却是以10倍成本为代价,如果按照目前每日100亿搜索查询来计算,每年增量成本将达到数十亿美元。

这样的方式,对于生成式AI产业生态,如OEM厂商,独立软件开发商以及应用开发者而言也远非经济实惠,从而限制了生成式AI在全球范围内的规模化普及。

过去数年,高通全球副总裁兼高通AI研究负责人侯纪磊博士一直在带领团队进行终端AI方面的技术创新和实践探索,据侯纪磊介绍,在AI领域的合作中,高通发现,仅仅依靠云端处理,若要实现一定水准的服务能力,相应的覆盖性或者拓展性就会不足。

“云经济难以支持生成式AI的普遍发展。从成本角度出发,我们的合作伙伴也希望通过运用终端侧的能力来分摊成本。在云端仍然可以建立一个基于GPU群的强大的运算网络,而当终端侧能够具备强大的计算能力、可以分摊计算成本时,合作伙伴就会对此倍感期待。”侯纪磊告诉集微网。

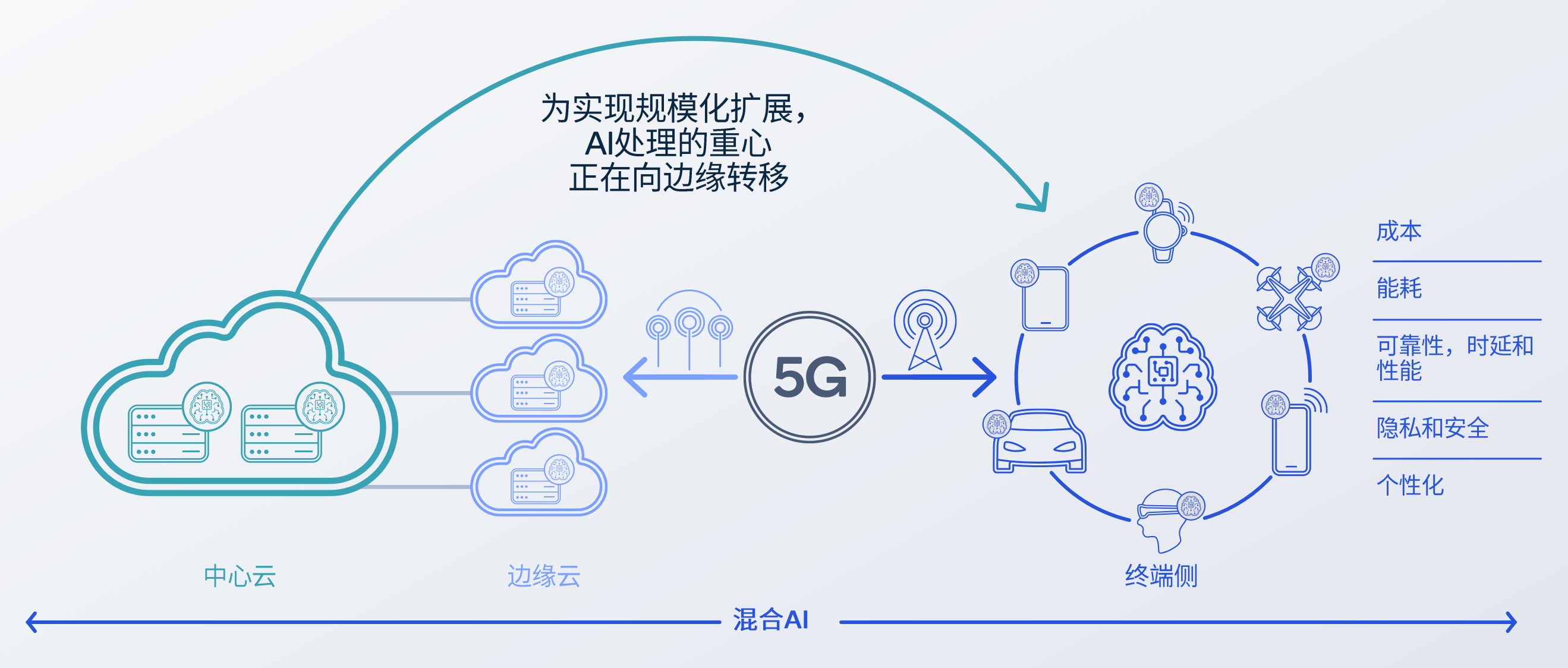

这便是高通提出混合AI架构概念,并受到业界广泛关注和接受的原因。简单而言,混合AI的理念是以终端AI和云端AI协同,结合场景需求,合理分配AI计算工作负载。这样,既能够发挥云端在算力方面的优势,也能够发挥终端AI在成本、效率、隐私、安全、个性化、能耗等方面的诸多优势,形成互补,带来更好的终端设备体验,推动生成式AI规模落地和普及。

把大模型装进手机

今年的MWC上,高通在搭载第二代骁龙8移动平台的手机上,进行了全球首次端侧运行超过10亿参数模型,基于文本输入生成图像的Stable Diffusion演示,且性能和精确度水平达到与云端相似的水平。

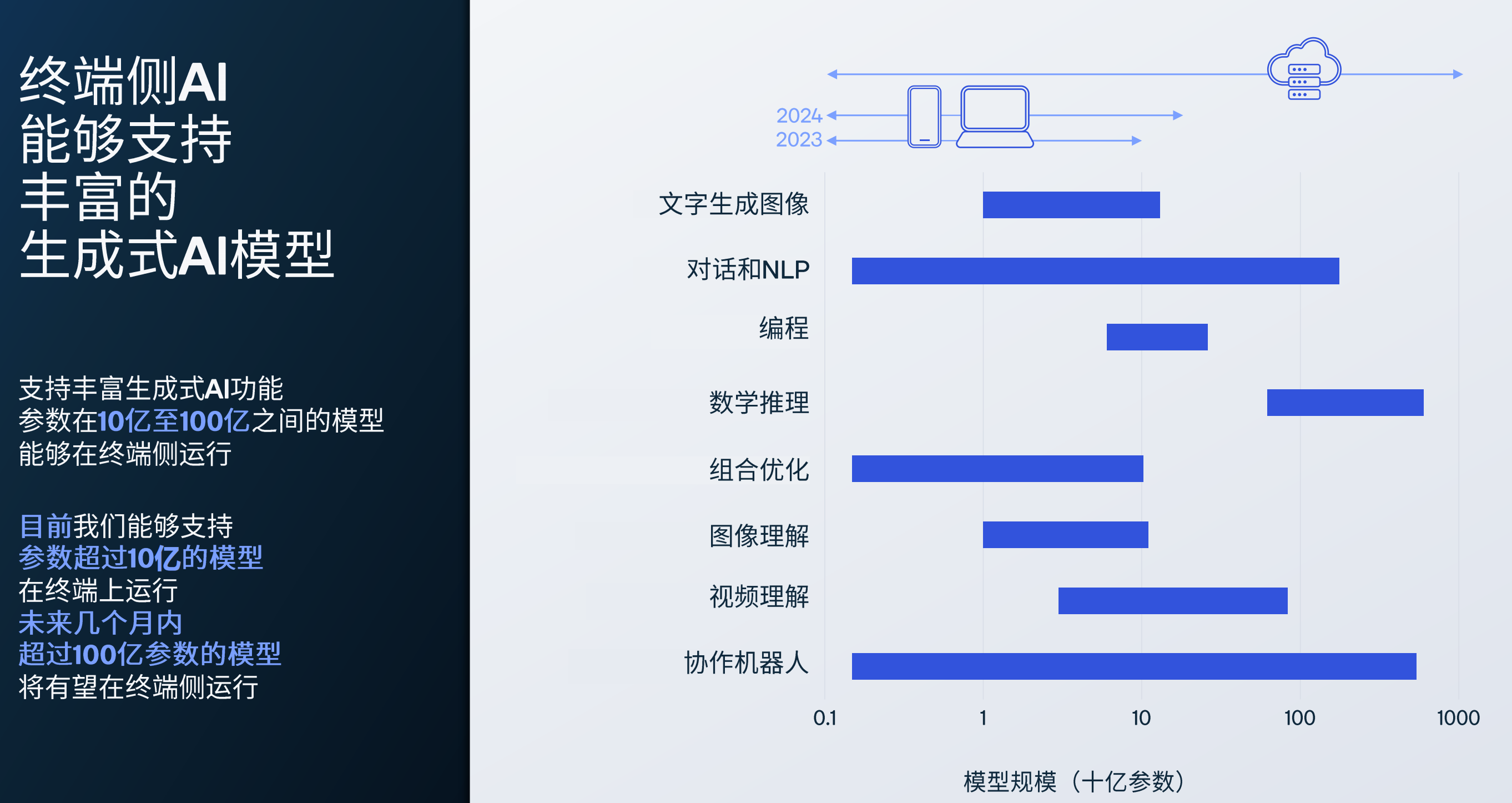

上个月,高通演示了终端侧支持15亿参数的ControlNet图像生成图像模型,无需访问任何云端。据集微网了解,高通今年年底前以及明年,有望实现支持参数达100亿和200亿的模型在终端侧运行。

将更多生成式AI用例向边缘侧迁移,需要不断提高模型参数阈值。高通的研究显示,从目前针对不同应用需要的模型规模看,主要集中在50-200亿参数区间,而高通的一系列创新实践表明,终端侧已经具备支持生成式AI落地的基础。

一方面,目前的一些开源模型以及科研成果表明,通过调优等手段,达到同样性能效果的模型参数可以更小。比如Meta发布的130亿参数规模的大语言模型LLaMA,在足够多语料的支撑下,性能能够媲美参数达1750亿的GPT-3。

另一方面,在终端侧的一些应用场景中,只是对大模型的语言能力具有要求,而非知识能力(及时更新数据),一些参数规模较小的模型就已经能够胜任要求。

据侯纪磊博士介绍,衡量终端侧运行大模型性能的关键指标是Token Rate(平均数据速率),特别是随着模型参数规模的提升,Token Rate需要保持在一定指标范围内,从而保证最终用户体验上的一致性。而无论是大语言模型或Diffusion Model的一部分模型参数,都涉及内存计算,这使得从DRAM到SRAM读取过程中的带宽成为重要指标。

此外,无论是大语言模型还是Stable Diffusion等模型都大量地使用了转换器(Transfomer)中的一种注意力机制——注意力模块(Attention Module),其在时限上的有效性和简洁性也非常重要。

“因此,无论是从系统级(SoC)上的带宽优化,还是针对注意力机制在算法上进行调优,以及如何从新一代的加速器层面对注意力机制产生更好的计算表现等方面,这都是大模型在终端实现落地的关键之处。”侯纪磊强调。

AI创新的两个闭环

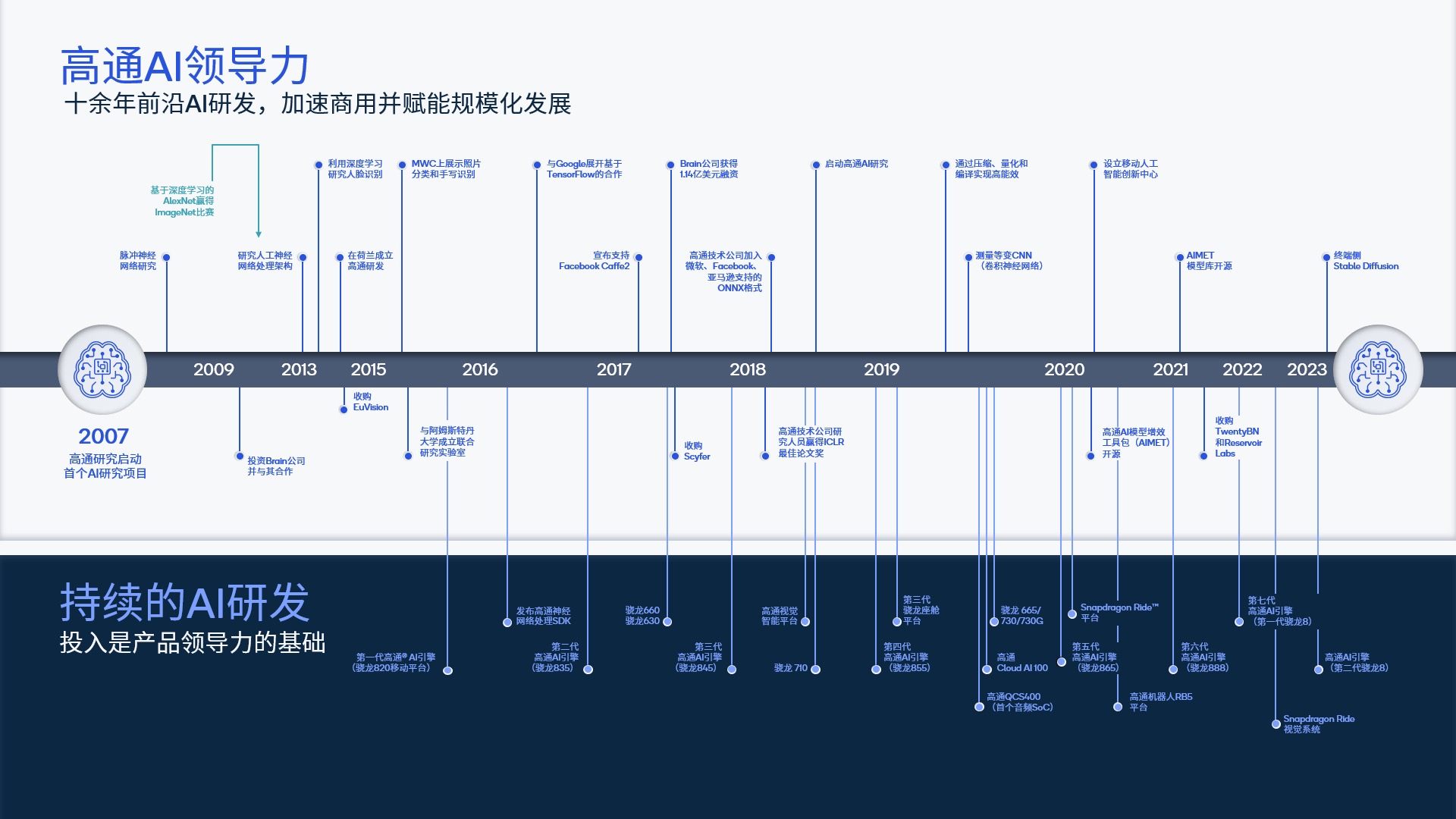

能够率先实现生成式AI终端侧落地,得益于高通十余年来在AI领域的深厚积累以及在生成式AI领域的前瞻性布局。

2007年,高通首个AI项目启动,踏上人工智能的研发之路,并致力于推动终端侧AI的规模普及。2018年,高通AI研究院成立,进一步强化整合公司内部的前沿人工智能研究。数年前,高通便着手生成式AI的研发工作。

侯纪磊认为,在终端AI的研发创新及推动落地方面,高通形成了两个闭环。

一是从基础研究到落地、产业合作,到再度助力研究的创新成果转化;二是从硬件、软件、算法层面形成端到端的全栈优化能力。这对于积累和推动高通在AI方面领先研发优势以及推动技术最终落地方面,都带来非常大的帮助。

截至目前,高通在AI领域顶级学术会议上发表论文超过150篇,有力推动了前沿理论创新。

高能效是高通端侧AI的显著特点,以量化、条件计算、神经网络架构搜索、编译为代表的整体模型效率研究是高通高效能AI研发中的重要组成部分。2020年,高通在国际机器学习顶会ICML上发表的一篇重要研究成果,其中包括AdaRound量化研究算法等一系列先进的理念和技术,为后续高通将Stable Diffusion以及大语言模型引入端侧奠定了基础。

在积极推动相关学术研究的同时,高通也会定期将成果放到开源工具包AIMET中,也有助于快速实现商业化,推动行业向整数推理和高能效AI方向发展。

此外,在高效能AI方面,高通在包括硬件、算法和软件等方面进行了大量的研发创新。这种全栈式AI创新和优化,也成为高通AI研究的重要原则。

据侯纪磊介绍,在高效硬件方面,通过对高通移动平台中CPU、GPU、NPU等不同单元进行优化,最终使得针对不同任务,能够选择合适的计算模块运行;在算法层面,高通顶尖的深度神经网络算法团队做出了很多原创性的研究成果,并在开源方面做出了很多贡献;在软件方面,在面向深度学习的软件加速runtime以及SDK/开发框架方面,高通对于客户以及开发者也做出了很好的支持。

“通过跨层的模型、硬件和软件创新加速AI应用,这种早期研发和技术发明对于引领生态系统发展至关重要,而最终将技术转让给商业团队,并通过部署过程中的收获来影响未来的研究,形成正向循环。”侯纪磊说。

混合AI的生态协同

混合AI架构涉及终端和云端计算的协作,因此,除了终端侧自身能力的提升外,如何同云端形成有效的协同机制也是推动端侧AI规模落地以及广泛普及的重要因素之一。

侯纪磊认为,这首先涉及通信机制问题。无论是在云端还是终端,都存在大量的应用程序编程接口(API),很多情况下,需要判断终端和云端的交互信息内容和形式,因此需要建立标准,以便于不同终端(如OEM)能够和不同云端之间实现互联互通。

其次,大语言模型面临知识库的更新问题。在当前微软、谷歌以及OpenAI的早期研究以及落地的一些产品中,通过在机制中引入编排器(Orchestrator),根据每次输入的提示(Prompt)进行判断,如果大语言模型本身具备能力则直接完成输出。但更多的情况下,编排器需要寻找大模型之外的外部数据库(Database)支持。

比如,微软通过Microsoft Graph与第三方开发者对接,以插件的方式引入第三方的信息,调取外部更新的知识并导入到大语言模型,再产生最终的输出结果。

这个涉及大语言模型、用户接口、编排器,以及外部知识库的一整套流程,在微软的体系被称为助手协议栈。但通常而言,协议栈所涉及的内容都在云端。对于混合AI或终端AI而言,需要着力解决的是,在涉及不同操作系统的嵌入式环境中建立一套类似机制,能够与微软或其他厂商的云端能力对接。

因此,实现生成式AI终端侧的落地,以及混合AI的协同发展,需要集聚产业生态的共同力量。

“某种意义上这是生态链的能力,也可以说是涉及基于大语言模型应用生态链诸多组成部分协作才能共同完成。通过开发混合AI,我们致力于推动终端侧的能力,并使之在具备能力之后,与云端之间进行大量协调,这是充满挑战的。”侯纪磊坦言。

据侯纪磊介绍,目前高通正在围绕混合AI开展生态链体系的建设,包括同国内的一些合作方也就此展开交流与合作,希望共同推动这一领域的发展。

交互方式的变革

生成式AI的引入,将催生终端侧的革命性变化。就智能手机而言,最显著的变化是与用户交互方式发生了根本性的转变,人们可以通过自然语言与手机进行对话。

“此前,用户与手机进行互动时,需要通过操作应用(App)来让手机完成指令,用户需要适应这些应用、需要对应用的操作有所了解。但最为理想的交互形式是个人数字助手能够像公司助理一样,通过自然语言的方式把需要完成的事情交代给助理,助理就可以把这些事情全部很好地完成。在这种情况下,个人数字助手相当于成为了用户的代理(Agent),由它与各个应用直接交互,完成很多事情。”侯纪磊说。

侯纪磊认为,在此过程中通过自然语言与数字助手之间的沟通,数字助手也积累了大量的用户个人信息,甚至比用户更了解自己,因此它在向用户做个性化、定制化的推荐、安排各类事务时,可以使用户的生活得到很多方便和改变。

“长远看,这也将在交互层面,改变用户与各种应用的互动方式,或许未来只有一个APP——数字助手。”侯纪磊说。

而对于手机侧生成式AI的引入,侯纪磊认为同样需要生态链的共同参与。

“目前来看,手机厂商在云端、终端侧,乃至生态链上,都积累了强大的能力。因此,目前相互之间需要不断地互动、交流,从而实现合作共赢。我们在与包括手机厂商在内的生态伙伴合作时,需要基于大模型应用的生态链,针对终端侧进行大量布局和发展,填补终端侧相较云端还存在的能力上的空缺,这是需要大家通过合作来实现的目标。”侯纪磊强调。

在侯纪磊看来,目前整个行业都看到了生成式AI在交互方式等方面所带来的巨大潜力和机遇,不论是来自手机、PC、还是汽车行业的厂商,都非常积极地在拥抱生成式AI。因此,在今年下半年,会在各个行业看到不错的用例出现。

“一些在技术铺垫和产业化思路进展较快、较为成熟的企业会拥有更大的成功机会,而高通也会比较注重跟这类企业的合作。”侯纪磊说。

终端AI的未来

毫无疑问,生成式AI将影响各类终端上的应用场景,在智能手机上运行Stable Diffusion只是开始。

高通所具有的全栈AI研究和优化能力,边缘侧布局和规模化的优势,以及统一的技术路线图,使其能够实现跨终端平台的AI赋能,这将极大推动终端AI的落地和规模普及。

在上个月举行的2023年国际计算机视觉与模式识别会议上,高通提交了8篇重磅论文,并进行了诸多将生成式AI引入边缘侧的创新技术演示。其中包括手机上运行全球最快的ControlNet图像生成图像模型、全球首个在手机上进行的1080p神经网络视频编码、面向XR的3D重建、为增强安全性的驾驶员监测技术、XR虚拟头像等。

可以看到,在手机、PC、XR、汽车、物联网等高通的业务领域,AI的能力正在终端侧加速渗透。同时,在大语言模型方面之外,高通还在积极探索视觉等其他多模态输入模式结合,使得大语言模型能够具备与物理世界交互、进行推理的能力。

侯纪磊认为,多模态是生成式AI未来必然的演进方向。前文提及的编排器(Orchestrator)将来可能演进成为代理(Agent),当代理变为多模态后,能够将简单的任务组合成更复杂的任务,实现自主运行,做更复杂的事情,为人类提供更多帮助。

对于高通的混合AI未来发展之路,侯纪磊指出,高通将首先通过和头部大厂的合作,基于双方的技术能力,共同将先进的概念推广出去。然后通过与第三方厂商合作,将生态链建设起来,纳入更多的长尾应用。同时,将重视开源社区的建设,形成协调互动的生态,共同加速推动终端侧AI的应用落地。

“终端侧AI具有诸多优势,是让AI无处不在的关键。混合AI是AI的未来,也是未来能够支持生成式AI、大语言模型等能够实现全球化、规模化发展的重要手段。通过高通的终端侧AI领导力,包括无线连接,高效计算,分布式AI等方面,使得我们能够通过与业界的合作带来更多的创新,支持生成式AI规模化扩展。”侯纪磊说。

登录

登录