作为本轮技术革新的iPhone时刻,ChatGPT的发布标志着新一轮AI技术革新的开启,伴随而来的是新一轮下游需求的大爆发,尤其是训练和推理算力芯片“扶摇直上”。

尽管大模型数量的倍数级增长,让训练芯片GPU成为当红“流量”,但随着AI应用的逐步落地,更多算力从模型训练转移到AI推理工作中。据IDC数据,2021年中国数据中心用于推理的服务器的市场份额占比已经过半,达到57.6%,预计到2026年,用于推理的工作负载将达到62.2%。此外,边缘计算增势强劲,预计到2030年全球市值将激增至4450亿美元,而在边缘和客户端市场对推理的需求相比数据中心更超过了1.4倍。

多位行业人士认为,在AI算力时代,异构计算将大行其道。而在各种异构计算的组合中,CPU均是当仁不让的主角。目前AIGC仍处于开发和研究初期阶段,CPU既可进行通用计算,其高性能、低功耗的特性也将在推理端进一步放大,有望在未来的AI推理市场占据主力,产业格局亦将产生分化。

推理成角逐重心 CPU担当重任

在群雄逐鹿的大模型市场,尽管看起来热闹非凡,但在英特尔数据中心与人工智能集团副总裁兼中国区总经理陈葆立看来,无论是生成式AI或是大模型,都还处于比较初期的阶段,新的模型、新的场景将不断涌现,业界也在着力探索应用落地。

“从走向来看,美国如谷歌、Meta、微软等巨头,有实力持续扩充大模型,这些大模型均需要训练,因而需要万卡集群。但多数中小企业还是着重于调用模型开发应用,大企业也会着力,如微软的Copilot即调用模型进行微调和推理。”陈葆立进一步表示,“从中国市场来看,虽然步态不一,但百模大战也会走向聚合,如何应用大模型支持更多的垂类应用已是业界关注焦点,这也使得推理的用量将快速提升。”

有分析称,在推理之后还需要做分析和增值计算,这也是通用计算CPU的强项。测试表明,在大语言模型等领域进行200亿参数及以下中小规模参数的推理,英特尔新推出的第五代至强处理器具备更佳的性价比,可将推理性能提高42%,延迟低于100毫秒。

阿里云服务器研发事业部高级总监王伟也提到,尽管万亿级或更大参数规模的模型仍将推出,模型发展始终在加速,训练的诉求仍以GPU为主。但行业在从早期萌芽走向后期成熟,更多的AI应用场景将倾向于推理,要根据算力和功耗等需求采用不同的处理器架构如CPU、NPU等,以满足多元化场景的需求。

王伟进一步提到,阿里云最近在第八代服务器进行了各种AI应用的尝试,发现CPU已不惧生成式AI挑战,可轻松支持各种生成式AI模型,如阿里云通义、Stable Diffusion等等。阿里已在尝试用CPU跑一些较大规模的推理,如12B、70B/72B的模型,目前已经可以在阿里云第八代ECS实例上运行,未来将在这一方面进行更多尝试。

对此火山引擎IAAS产品负责人李越渊也分享道,在大模型规模不断增加的情形下,服务器首要强调弹性的能力,之后要考虑性价比。对于闲置的集群,对成本的容忍度不高。随着CPU的AI能力越来越强、性能越来越好,CPU的性价比将更佳。目前火山引擎已与一些大客户合作,采用CPU部署大规模模型的推理。

联想到前不久英特尔基辛格的观点,即AI 并不能只依赖训练,推理才是真正可行的方式,才是竞争的焦点,一切或已然明了。“无论是在边缘端还是在数据中心,未来推理的业务量会持续增加,推理芯片的需求量也将迎来强劲增长,在未来的推理领域CPU的潜能正待释放。”陈葆立对此十分乐观。

适应推理需求 CPU走向革新之路

生成式AI的兴起,让异构计算的组合在发挥不同的威力,而在各种组合当中CPU仍是不可或缺的主角。在行业人士看好CPU在推理领域的“价值”之后,要进一步发展和适应大算力的需求,CPU的“革新”也不得不发。

李越渊对集微网记者提到,无论是训练前对数据的预处理,快速、高效将“待处理数据”变成为模型所用的高效数据,还是多元化模型的推理,对于AI算力、内存、带宽、互联互通等均提出更高的要求。

“以通用计算为主的CPU,通过集成AI加速器,可在推理层面发挥SoC内部集成的向量执行单元、高并发执行单元进行AI并行加速。而增加了内存带宽和Cache,有利于未来通过CPU促进生成式AI应用场景的落地。目前来看,建议未来CPU厂商更多关注内存带宽和容量方面的革新。”王伟也提议道。

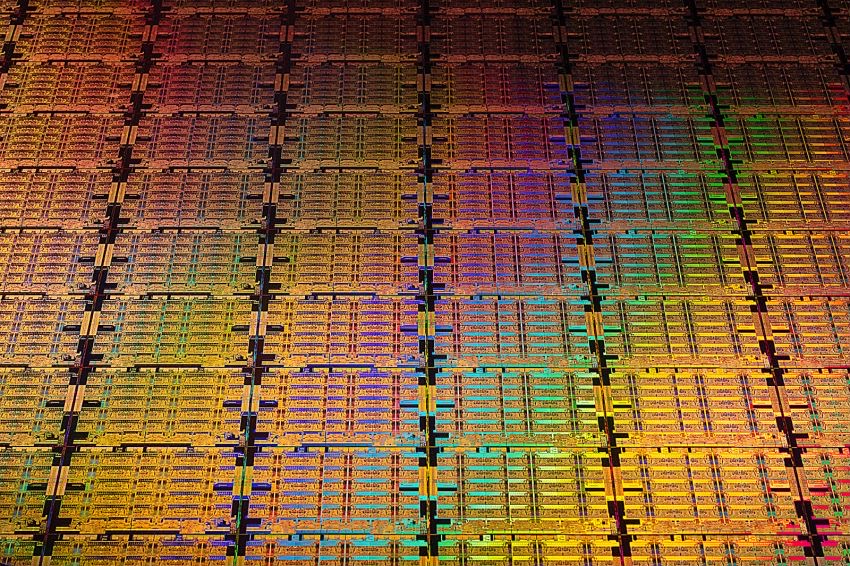

众多CPU厂商围绕AIGC算力需求已在排兵布阵。持续致力于AI无处不在的英特尔,迅速推出第五代英特尔至强可扩展处理器(Emerald Rapids,以下简称第五代至强),以及为端侧AI PC打造的酷睿Ultra处理器。

无论是AI算力、内存、带宽、互联互通等层面,上述新品都实现了全面“升级”,功力也随之大增。作为在一年内进行的第二次发布,第五代至强拥有多达64个核心,三级缓存是上一代产品的近3倍;具备8条DDR5通道,支持高达5600MT/s的传输速率。此外,每个内核均具备AI加速功能,相较上一代产品算力提升高达21%,每瓦性能提升高达36%。对于遵循典型的五年更新周期并从更前一代处理器进行升级的客户而言,总体拥有成本最多降低77%。该产品在京东云、百度智能云、阿里云、火山引擎的成功实践及其应用价值受到客户广泛认可。

对此王伟也提到,搭载第五代至强处理器的阿里云第八代ECS实例在多媒体、数据库、数据加速、数据加解密甚至是AI推理应用上实现了极好的效能表现,这受益于在L3 Cache和内存带宽上的改进,以及加速引擎的提升如Intel AMX。

作为端侧算力的主力,轻量化模型和开源模型生态的壮大为AI PC开启了商机。目前,英特尔、微软、三星电子、华硕、联想等均在布局AI PC产品,2024年有望成为AI PC的元年。

着眼于此,英特尔酷睿Ultra处理器可谓“集大成之作”。首款基于Intel 4制程工艺打造,采用了先进的Foveros 3D封装,集成多达16个CPU核心,最高达到5.1 GHz的频率。同时还集成了英特尔锐炫GPU,拥有最多8个Xe核心,图形性能最高约为前代产品的2倍。加之结合英特尔最新的NPU,与前代相比带来2.5倍的能效表现。此外,还提供最高支持64GB的LP5/x或高达96GB DDR5的内存支持。除此之外,英特尔还宣布将与主流OEM伙伴推出230余款机型,开启AI PC新纪元。

生态至关重要 开放超越封闭

在着力推出一系列出色的AI产品组合之际,折射出英特尔的雄心壮志:旨在助力用户从数据中心、云、网络到边缘和PC等各个领域打造无处不在的AI解决方案。

这当中,生态可谓AI版图中的重量筹码,英特尔也在多路并进。

为推动AI硬件技术普及并易于使用,英特尔正在加快建立一个开放的AI软件生态系统,以打破专有的封闭式生态系统格局。英特尔在持续优化开发者使用的AI框架如PyTorch和TensorFlow,并通过提供先进的开发套件包括oneAPI和OpenVINO工具包,助力开发者利用硬件加速功能处理AI工作负载和部署解决方案,在各种推理目标上快速构建、优化和部署AI模型。

陈葆立介绍,OpenVINO工具套件能够帮助开发者减少代码修改次数和自动设备检测,通过将工作负载分配到合适的计算引擎,提升AI性能表现,并通过ONNX和ONNX Runtime流程优化相结合,以实现更快的推理过程。

为持续推进AI应用落地,陈葆立还强调,明年英特尔将发力于软件生态扩大“朋友圈”,加强与开发者的互动。“在生态部署以及开源社区合作层面,英特尔将持续投入,着力构建一个开放的加速器软件生态系统,与合作伙伴一起加快构建一个成熟的开发者社区,进一步简化跨平台部署应用的开发。”

随着AI正朝着从云原生开发转向边缘人工智能原生开发的方向迈进,英特尔在AI PC的布局成为“借力”支点。正如英特尔执行副总裁兼客户端计算事业部总经理 Michelle Johnston Holthaus 所言,“AI PC将在未来四年内逐步成为主流,占据 80%的PC市场份额。” 英特尔还提出了“AI PC加速计划”,将为软件合作伙伴提供工程软件和资源,以在2025年前实现为超过1亿台PC实现人工智能特性。

显然,AI PC的体验效果深受其所配备软件的性能影响,遇强则强。作为AI PC加速计划的一部分,超过100 家独立软件供应商(ISV)和300余项AI加速功能将针对英特尔酷睿Ultra处理器进行专属优化,提供丰富的AI应用程序和框架。在PC之外,英特尔酷睿Ultra处理器还在边缘计算领域提供高能效的AI加速功能,支持要求严苛的视觉处理任务,并在医疗健康、零售和制造等垂直市场推动创新。

英特尔CEO基辛格曾说过:“当你拥抱推理时,一旦你训练好了模型就不需要再依赖于CUDA。”而王伟的观点与此有异曲同工之处:生态有封闭性和开放性,从长远来看,产业不会让任何一个封闭的生态主宰的。PyTorch的框架和引擎的开源发展,也是为了让算力更普惠,更普适于不同的硬件芯片和不一的模型。