1.负债超2000万!老牌PCB厂华颖电子破产清算进入最后阶段;

2.英伟达黄仁勋预测人工智能将在五年内通过图灵测试;

3.英伟达成台积电第二大客户,去年占台积电营收 11%;

4.苹果停止Apple Car研发 郭明錤:资本市场并不在乎;

5.AI时代与英特尔Foundry,互相需要;

6.AI浪潮席卷 存储再进化

1.负债超2000万!老牌PCB厂华颖电子破产清算进入最后阶段

全国企业破产重整案件信息网显示,2月28日,惠州市华颖电子科技有限公司(华颖电子)新增一则“财产分配”信息,该公司的破产清算程序进入最后阶段。

2020年3月24日,惠州市中级人民法院就曾宣告华颖电子破产。但后来因为其“财产不足清偿破产费用、无财产可供债权人分配”,不得不终结该公司的破产程序。直到2023年底,华颖电子获得一笔损害赔偿,才有了可供执行的财产。

目前,华颖电子可供清偿的破产财产总额为360,101.78元,其中,包括:收取的污水处理设备设施补偿款360,000.00元和管理人账户结息收入101.78元(暂计至2024年2月28日)。

管理人审查确认并经惠州市中级人民法院裁定确认16家债权人申报的债权,债权总额为20,572,218.60元,其中普通债权20,287,853.65元,劣后债权284,364.95元。

全国企业破产重整案件信息网债务人信息显示,华颖电子的经营范围为生产、销售、单面、双面、多层印刷线路板(PCB),销售电子元器件、绝缘材料(依法须经批准的项目,经相关部门批准后方可展开经营活动)。

2.英伟达黄仁勋预测人工智能将在五年内通过图灵测试

据报道,英伟达首席执行官黄仁勋表示,从某些定义来看,通用人工智能可能会在短短五年内问世。

黄仁勋在斯坦福大学举行的经济论坛上回答了一个问题,即实现硅谷长期目标之一——创造能够像人类一样思考的计算机,需要多长时间。

黄仁勋表示,答案很大程度上取决于目标如何定义。 如果定义是通过图灵测试的能力,通用人工智能(AGI)很快就会到来。

“如果我给出一个人工智能……你能想象到的每一个测试,你都会列出测试清单并将其放在计算机科学行业的前面,我猜五年后我们会做得很好。”黄仁勋表示。英伟达的图形处理器应用于 OpenAI的ChatGPT 等系统之中。该公司的市值在周五达到2万亿美元。

截至目前,人工智能可以通过律师资格考试等测试,但在胃肠病学等专业医学测试中仍然举步维艰。 黄仁勋表示五年之内应该也能通过其中的任何一个。

但黄仁勋表示,按照其他定义,AGI 可能还很遥远,因为科学家们对于如何描述人类思维如何运作仍存在分歧。“因此,作为工程师很难实现”,因为工程师需要明确的目标。

黄仁勋还提出了一个问题,即需要增加多少芯片工厂(业内称为“晶圆厂”)来支持人工智能产业的扩张。 有媒体报道称,OpenAI 首席执行官Sam Altman 认为需要更多的晶圆厂。

黄仁勋表示,还需要更多芯片,但随着时间的推移,每个芯片的性能也会变得更强劲,这会限制所需芯片的数量。

“我们将需要更多的晶圆厂。但是请记住,随着时间的推移,我们也在极大地改进(人工智能)的算法和处理。”黄仁勋表示, “计算效率并不会停留在现今的水平。在 10 年内,我将会把计算能力提高一百万倍。”

3.英伟达成台积电第二大客户,去年占台积电营收 11%

有消息称,英伟达已成为台积电的第二大客户,仅次于苹果公司。

台积电通常不会披露和客户之间的关系,不过根据美国的相关法律,必须披露占其收入 10% 以上的客户的数据。金融分析师 Dan Nystedt 分析认为,2023 年英伟达占台积电营收的 11%。

2023年英伟达公司向台积电支付了 77.3 亿美元,其份额占台积电营收的 11%。台积电前十大客户占去年净营收的91%,高于 2022 年的82%。这些公司还包括联发科、AMD、高通、博通、索尼和美满电子。

人工智能设备的需求不断增长,英伟达在台积电的营收份额将在2024年增加。英伟达的尖端产品,包括 H100 和 A100 人工智能加速器,在台积电工厂制造。

苹果公司多年来一直是台积电的最大客户,在可以预见的未来,苹果在台积电的地位不会变化。

4.苹果停止Apple Car研发 郭明錤:资本市场并不在乎

日前,针对苹果停止造车一事,天风国际证券分析师郭明錤在社交媒体撰文指出,苹果停止Apple Car看上去是个大新闻,但资本市场一点都不在乎。

“看似一件大事,但全世界没有一档股票因为这件事而大涨或大跌,如果有请提醒我,谢谢。资金是很老实的,这代表资本市场早就不在意苹果是否要开发 Apple Car 这件事。”郭明錤表示。

此外,他也透露根据他的最新调查,苹果已经取消了 Micro LED Apple Watch 的开发计划,原因在于苹果认为 Micro LED 并不能显着提升产品附加价值,加上生产成本过高,不具投资效益。苹果已经遣散了 Micro LED 开发团队中大部分的人,目前所有 Micro LED 相关计划已无任何能见度。这对希望掌握下一代显示器技术以提升产品竞争力的苹果来说,无疑是一大挫败。

郭明錤还提及,Osram 是苹果的 Micro LED 独家晶片供应商。该公司取消与苹果的 Micro LED 合作,意味着在可见的未来苹果已经没有量产 Micro LED 装置的计划。

5.AI时代与英特尔Foundry,互相需要

2023年,生成式AI的现象级表现,让半导体行业呈现冰火两重天的局面。大多数半导体企业在行业周期底部苦苦挣扎时,英伟达却交出了一份创纪录的业绩答卷,这份答卷也成为了AI驱动半导体新一轮发展的故事序言。

2024年伊始,ChatGPT之父Sam Altman关于芯片的7万亿美元计划一度引起全球哗然,对于该计划的内容无从考究,但有Altman身边人士告诉笔者,该计划绝非空穴来风,Altman甚至已经向台积电明确提议新建3座3nm以下节点的晶圆厂,但遭到了后者婉拒。面对这种天马行空的合作需求,台积电定不会冒然接受。

此事在近日张忠谋的公开发言中得到了一定程度的印证,据问芯报道,张忠谋在台积电熊本厂开幕致辞中表示,有一位AI相关人士提到未来需要的晶圆厂数量时,他没有全然相信。

私下遭到台积电婉拒的Sam Altman,于今年2月英特尔Foundry举办的活动中公开亮相。正是在这场活动中,英特尔宣布将Intel Foundry升级成一家面向AI时代的系统级代工厂,并立下2030年成为全球第二大晶圆代工厂的长远目标。

在这场汇集了英特尔1000多位上下游合作伙伴的活动中,与Intel Foundry本无直接业务往来的Sam Altman却单独与英特尔CEO Pat Gelsinger进行了长达45分钟的炉边谈话,引发无限遐想。

面向AI,面向未来

据悉,Sam Altman正致力于解决OpenAI对英伟达芯片的高度依赖问题,SemiAnalysis 估计,OpenAI 过去使用了约 3,617 台 HGX A100 服务器,其中包含近3万块英伟达 GPU。外媒报道称,OpenAI正拓展多种可能的解决方案,包括启动新的芯片供应商或开始自研专用AI芯片。

例如在2023年底,OpenAI就率先试用了微软为大语言模型训练和推理而设计的第一款AI芯片Maia 100,并在GPT-3.5 Turbo上进行测试。Maia 100虽采用台积电的5nm工艺代工,但微软CEO Satya Nadella在英特尔的活动中已经官宣,另一颗微软设计的芯片未来将采用Intel的18A制程节点生产。

Gelsinger曾表示,将在2024年底投产的Intel 18A制程能耗表现会领先于台积电的2nm工艺。微软采用如此领先的制程节点所打造的芯片必然与AI计算相关,未来也极有可能获得OpenAI的采用,这也意味着,OpenAI与Intel Foundry之间正开始建立某种联系。

此外,在Sam Altman的7万亿美元相关讨论中,OpenAI是否会自研芯片也是业内关注的重点。一位晶圆代工高管认为,在与台积电沟通建厂不顺之后,若OpenAI未来自研芯片,英特尔或许会是其代工厂的优先选择,后者甚至还可能会帮助其设计芯片。

Gelsinger在接受媒体采访时曾表示,英特尔需要更大的客户基础来推动实际产能提升,所以会希望承接一些芯片设计业务。

“这意义重大,因为很多客户在向我们承诺下单较大产能之前,会先让我们帮助做芯片设计,然后这些相对合同金额较小的芯片设计业务,将带来更大的代工业务承诺,”Gelsinger如是说。

此外,在与Pat Gelsinger的对谈中,Sam Altman还提到了“整合”对于AI的重要性,因为如果某一个环节出现问题,便会导致整个系统的效率低下。这与英特尔宣布的系统级代工概念不谋而合。

过去的系统级主要停留在封装层面,但英特尔代工市场营销副总裁Craig Org在接受包括集微网在内的中国媒体采访时则表示,英特尔探索的是全栈式系统,仅通过改变连接方式就能在使用相同技术的前提下将性能提到两倍,甚至更高。

“要获得与工作负载的增加相匹配的(算力)指数级提升,我们必须优化系统的每个层面,包括存储、网络、软件,所有这些都必须匹配在一起,”Craig Org进一步指出,“因此,我们要做的不仅仅是封装级别的,而是整个系统,还包含了如何放置存储,需要多少存储、多少带宽、多少网络等配置,以及如何将其映射到更高层次的软件、芯片架构和系统架构中,使其与软件,与数据的移动方式相匹配。”

未来Intel Foundry会与OpenAI擦出怎样的火花尚未可知,但对于整个AI时代而言,Intel Foundry顺应趋势所做出的调整一定会有所收货。这个充满挑战与机遇的全新时代,需要Intel Foundry这样强大的老牌芯片制造商焕发新生。

更适合英特尔的时代

3年前,英特尔提出IDM 2.0战略伊始,一位台积电高管便曾向笔者直言,即将独立并作为重点业务发展的英特尔代工厂很难获得成功,因为在过去长达数十年的运营中,英特尔晶圆厂的主要精力都是服务于该公司的产品部门,“没有Foundry的基因”。当继续追问何为Foundry的基因时,这位高管给出的答案是“开放和积累”。

关于缺少“开放”,是指英特尔产品容易与客户形成竞争,而台积电绝不会与客户产生任何形式的竞争,因此有更广泛的客户基础。

关于缺少“积累”,则是指英特尔在产品新老交替时,往往会摒弃旧工艺,仅维持1-2代新工艺。甚至会变卖旧设备升级新产线,导致每一代工艺无法经过长时间和多用户的打磨。反观台积电,经过长年累积,拥有包涵0.25μm到3nm的工艺平台纵深。

为尽可能解决“开放”问题,英特尔宣布将Intel Products与Intel Foundry作为两个全新的组织独立运营,两个团队之间将有一条清晰的界线(信息隔离墙)。Gelsinger还表示,英特尔今年开始将发布Intel Foundry的独立财务数据,目标是让工厂产能满载,向全球最广泛的客户交付产能,包括英伟达、高通、谷歌,甚至是AMD等等。在开放的同时,英特尔还会用自己产品推动Intel 18A和Intel 14A等新制程节点的质量提升,减轻所有后续客户的投产风险。

不仅如此,英特尔还对外提供更加开放的“服务菜单”,包括将(内部)产品组用到的技术开放给英特尔(外部)代工一侧,比如用英特尔的一些芯片与其它外部的芯粒进行结合。

“我们会对此表示支持,基于多种软硬件和芯粒的各种IP为客户提供定制的产品和服务,例如所需的安全芯片、其他I/O芯片或网络组件,”Gelsinger强调,“最终我们必须建立、赢得代工客户的信任。他们将获得英特尔最好的服务,他们的IP和供应链将得到保护,这是我们的承诺。”

即使一些芯片设计公司希望采用双代工厂的模式,英特尔代工高级副总裁Stu Pann也表示欢迎,因为对于当前正处于追赶者的英特尔而言,这种情况反而会帮助英特尔更快进入市场。

在解决“开放”问题以后,有关“积累”的讨论或许需要重新审视。因为当前晶圆代工行业正面临新的局面,一是全球晶圆厂产能利用率普遍较低,低价竞争趋势明显;二是成熟制程赛道拥挤,后来者的投入产出比不高。

这样的背景下,回头补足成熟制程平台并非明智之举,英特尔从当下做起,积累好AI时代所需要的各个先进节点平台才是一门好生意。而事实也是如此,据Gelsinger透露,在相当短的时间内,Intel Foundry的预期交易价值从40亿美元提升到了150亿美元。

目前,英特尔不仅“四年五个制程节点”计划进展顺利,还最新公布了下一阶段的Intel 14A及数个演化版本。至于成熟制程,英特尔则采用借力的方式,通过与联电和TowerSemi的合作,以为客户提供更丰富的工艺平台选择。

综上所述,英特尔没有选择弥补旧的“Foundry基因”,而是通过组织架构调整、建立全新的代工服务理念,以及持续对于制程创新的投入,打造出更适合AI时代的“Foundry基因”。

英特尔Foundry需要依靠AI时代的机遇重新获得领先,而AI时代也需要英特尔Foundry。

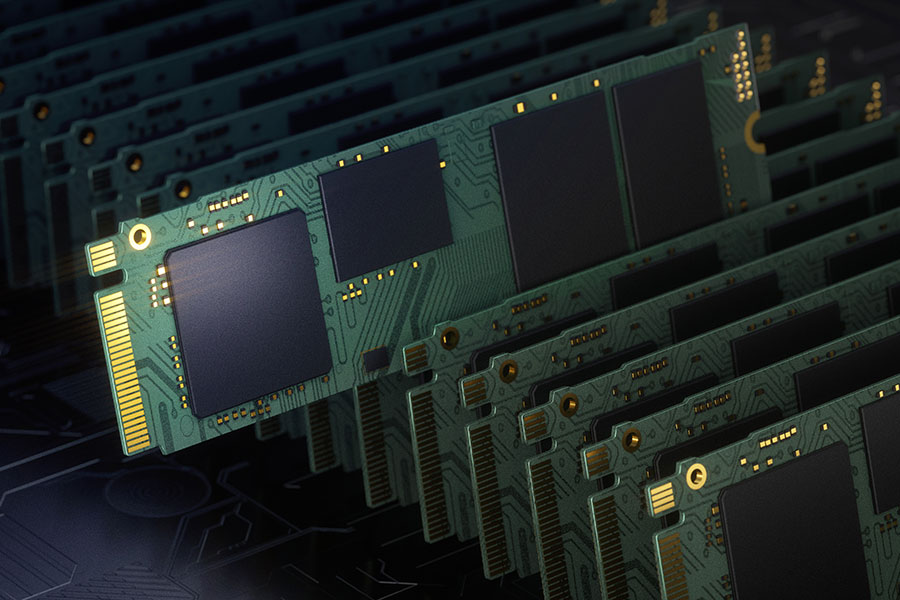

6.AI浪潮席卷 存储再进化

全球产业数字化,数字资料规模攀升,加上AI技术兴起,全球对数据处理、大数据分析与AI应用的需求快速增长,间接提高对支持高性能计算(HPC)与AI计算的硬件设备及芯片要求。以云端数据中心服务器来说,HPC与AI计算需求下,需要搭配升级的晶片包含作为芯片核心的中央处理器(CPU)与图形处理器(GPU)、服务器基板管理芯片(BMC)、电源管理芯片(PMIC)、高速传输芯片,以及存储等。

其中,存储除用于长期储存数据、属于非挥发性存储的NAND Flash固态硬盘(SSD),也包含用于即时高性能计算暂存数据、属于挥发性存储的静态随机存取存储(SRAM)与动态随机存取存储(DRAM)。

存储在芯片计算过程中的主要作用,是暂存计算过程中的中间值或参数。传统的暂存用存储可区分为芯片内部的快闪(Cache)存储与外部连接的DRAM。随着计算性能持续提升,芯片对内部与外部存储的容量与数据存取速率要求提高,特别是内部Cache存储。在封装的空间尺寸有限下,将小芯片(Chiplet)通过先进封装在单一芯片内形成更高密度的堆叠整合,成为提高芯片内部存储容量的重要选项。

先进封装技术发展针对芯片计算性能与功能持续提升的需求,通过中介层、硅穿孔与微凸块等技术达成2.5D/3D的小芯片堆叠,使厂商能在更小空间内达成更多计算单元与芯片功能整合。AMD的Ryzen 7 5800X3D芯片就是存储小芯片与CPU堆叠整合的例子:通过在CPU上方堆叠64MB的SRAM存储小芯片,将CPU原本32MB的Cache存储扩充为96MB,使CPU计算性能提升15%。

不过,用于HPC或AI计算的高阶GPU芯片,如英伟达的H100与AMD的MI300,其主要计算架构是以GPU计算核心搭配可快速大量存取传输数据的高频宽存储( HBM),二者通过先进封装技术,也就是台积电的CoWoS 2.5D封装技术在中介层上整合连接。

HBM是AMD与韩国存储大厂SK海力士、中国台湾联电、日月光等伙伴合作开发,SK海力士在2015年量产第一代HBM(HBM1),导入AMDRadeon Rx300 GPU芯片。随后韩国与存储大厂三星电子与美光也投入HBM开发。其主要结构是由多层DRAM存储小芯片形成的高容量存储垂直堆叠,最下层是HBM的控制芯片。堆叠中上一层DRAM与下一层DRAM间的信号通过微凸块连接,而上一层DRAM的信号可穿过下一层DRAM的硅穿孔与更下层的DRAM甚至最下层的控制芯片连接,再向下传递至基板。垂直堆叠的短距离确保层与层间的信号传输快速且耗能低,间接提升计算性能。

在CoWoS架构下,GPU计算核心可搭配多个HBM堆叠。目前全球已发展到HBM3的最新规格,在HBM堆叠数、垂直堆叠层数及层间讯号连接通道数都有增加;如从HBM2到HBM3,堆叠数可从八个增至16个,有效提升存储的数据容量与存取传输速率。

HBM主要是搭配GPU这类高计算性能芯片,本身主要结构采用3D堆叠的先进封装制作,再以CoWoS先进封装与GPU运算核心整合,形成完整的GPU芯片。若非GPU采用7纳米以下先进制程制作,是属于高单价产品,要以先进封装整合HBM的芯片生产成本是难以承受。在AMD Ryzen 7 5800X3D芯片的例子中,CPU上方堆叠SRAM小芯片,为提高存储容量,也需以先进制程制作SRAM,成本高昂。

针对智能物联网(AIoT)应用所需中等算力需求,有半导体厂商提出非先进制程计算芯片搭配客制化DRAM存储的解决方案,将存储与计算芯片以3D封装垂直堆叠。所谓的定制化DRAM存储,是根据计算芯片的电路与内连线的接触电极分布,设计出DRAM芯片的电路与数据存取传输通道位置,使计算芯片与垂直堆叠的DRAM小芯片之间能有高效率的数据存取传输,以提升计算性能。计算芯片是以AIoT应用所需的单芯片(SoC)或特殊应用芯片(ASIC)为主,而DRAM高于SRAM的存储密度,让DRAM小芯片在不采用先进制程下可拥有相当于SRAM小芯片的容量,也是成本优势。

中国台湾有存储厂商与晶圆代工业者、封测厂商、IC设计厂商合作,构建解决方案平台,依照应用需求,完成ASIC、DRAM以及二者封装连接与散热等需求的完整设计。无论是ASIC与DRAM都采用成熟制程制作,相较HBM、SRAM与先进制程计算芯片的组合,成本降低,可应对应用开发厂商对成本结构的要求。

为了应对日渐增加的AI应用,存储以小芯片或HBM等不同的样态,可通过先进封装技术与计算芯片形成单一芯片封装,支持不同类型的计算需求,也促成中国台湾半导体产业链跨领域多元整合的生态体系发展。

(作者是资策会MIC资深产业分析师,来源:经济日报)