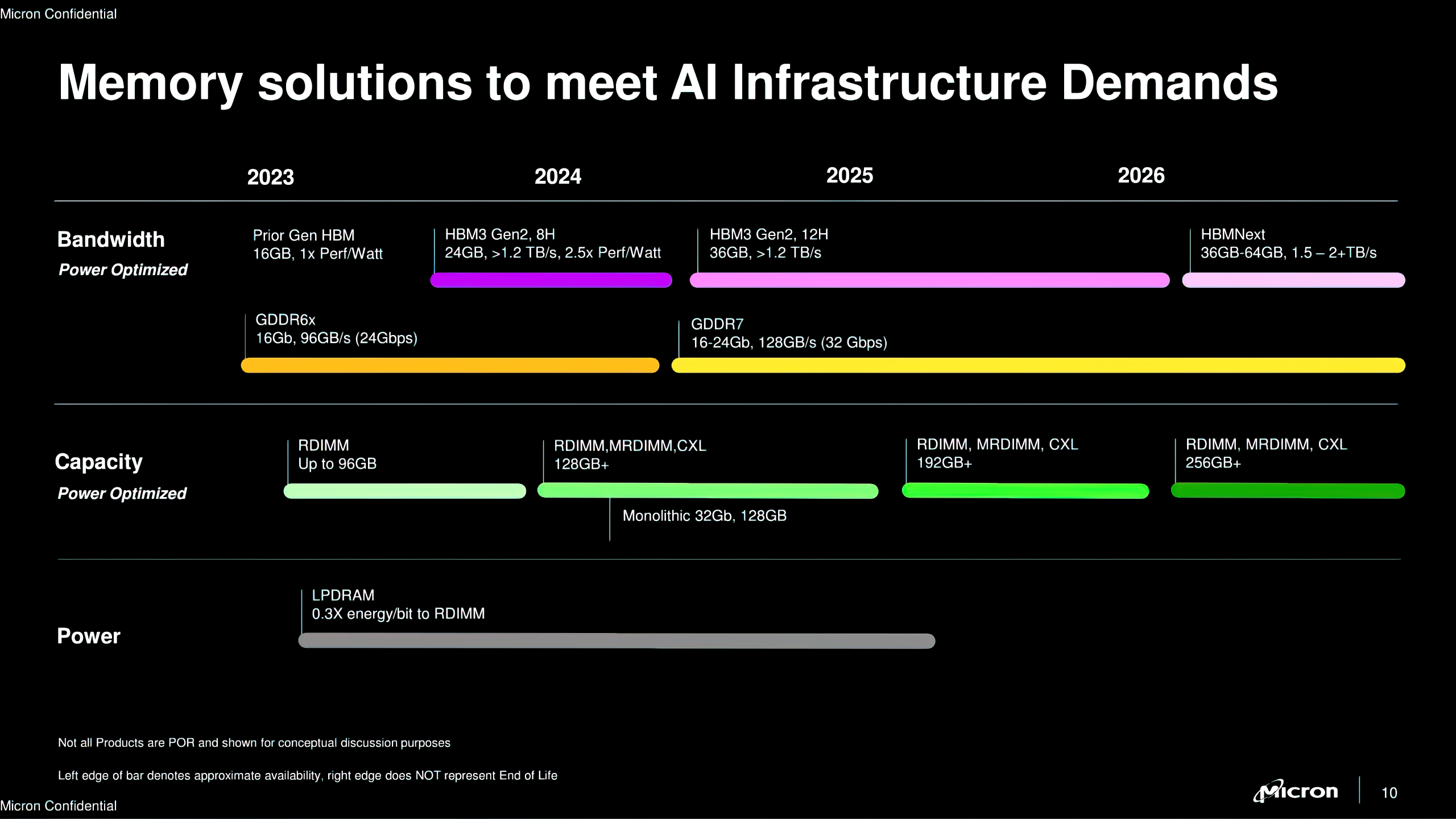

美光推出适用于下一代人工智能(AI)GPU的量产版12层HBM3E芯片,内存堆栈容量高达36GB,速度超过9.2Gb/s。美光表示,目前正在将可供制造的(production-capable)12层第五代HBM(HBM3E)送交给AI产业链重要合作伙伴,以进行验证程序。

美光9月9日正式宣布推出12层堆栈的HBM3E内存。新产品具有36GB容量,旨在用于AI和HPC(高性能计算)工作负载的前沿处理器,例如英伟达的H200和B100/B200 GPU。

美光的12层HBM3E内存堆栈拥有36GB容量,比之前的8层版本(24GB)高出50%。容量增加使数据中心能够在单个处理器上运行更大的AI模型。此功能消除了频繁卸载CPU的需要,减少了GPU之间的通信延迟,加快了数据处理速度。

在性能方面,美光的12层HBM3E堆栈可提供超过1.2TB/s的内存带宽,数据传输速率超过9.2Gb/s。据美光称,该公司的HBM3E不仅提供的内存容量比竞争对手高出50%,功耗也低于8层HBM3E堆栈。

美光的12层HBM3E包含一个完全可编程的内存内置自检(MBIST)系统,以确保为客户提供更快的产品上市时间和可靠性。该技术可以全速模拟系统级流量,从而对新系统进行全面测试和更快的验证。

美光的HBM3E内存设备与台积电的CoWoS封装技术兼容,该技术广泛用于英伟达的H100和H200等AI处理器封装中。

据悉,美光已开始开发其下一代内存解决方案,包括HBM4和HBM4E。这些即将推出的内存类型将继续满足AI处理器(包括基于Blackwell和Rubin架构的英伟达GPU)对高级内存日益增长的需求。(校对/孙乐)