2024年9月27日,第三届GMIF2024创新峰会在深圳湾万丽酒店圆满落幕。本次峰会云集了来自全球存储产业的领袖与专家,共同探讨AI时代下存储技术的前沿发展。北京大学集成电路学院院长蔡一茂作为特邀嘉宾,在峰会上发表了关于《AI时代的存储器与存内计算技术发展》的主题演讲。他从学术研究的视角出发,结合行业需求,深入剖析了存储器技术的现状及未来潜在发展路径,并指出存内计算技术将在AI时代背景下扮演更加重要的角色。峰会现场隆重揭晓了 GMIF2024 年度大奖的评选结果,蔡院长作为颁奖嘉宾,为Arm、长江存储、长鑫存储、兆易创新、佰维存储等多家在存储器创新领域做出突出贡献的企业颁发荣誉证书。

AI时代的存储挑战与机遇

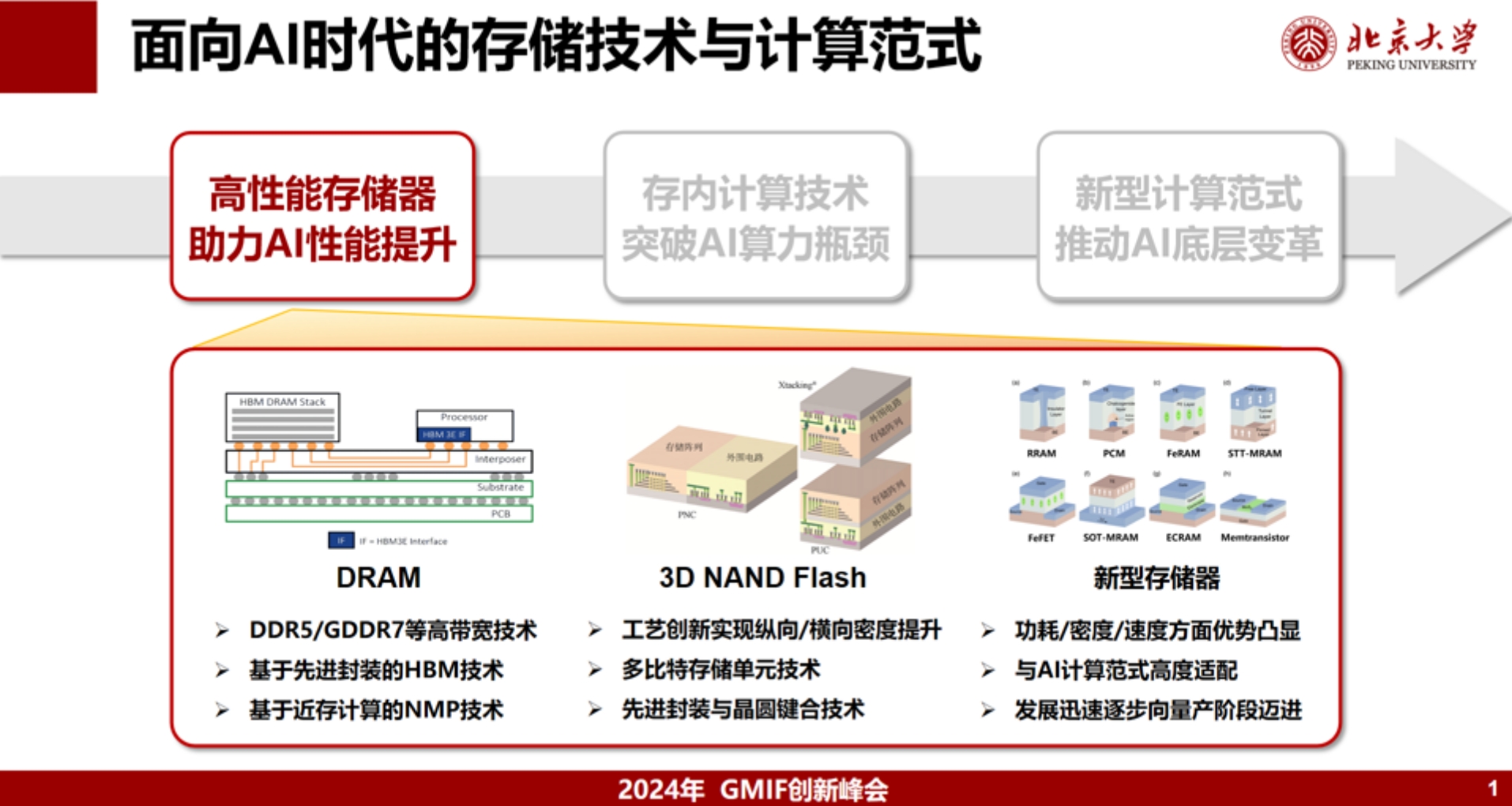

蔡院长在演讲中指出,随着人工智能(AI)技术的快速发展,全球存储器和计算系统正面临前所未有的挑战。AI应用对高效计算和低功耗的需求愈发迫切,但由于传统摩尔定律逐渐放缓,特征尺寸的微缩接近极限,使得系统级的算力和能效提升成为后摩尔时代的焦点问题。这不仅是芯片研发和制造层面的挑战,更是整个集成电路领域上下游产业链需要共同面对的问题。蔡院长提到,如何在有限功耗下,特别是“双碳”目标背景下,满足高性能计算需求,不仅是技术问题也是经济问题,需要学术界和产业界协同解决。

存内计算:突破传统计算架构的关键

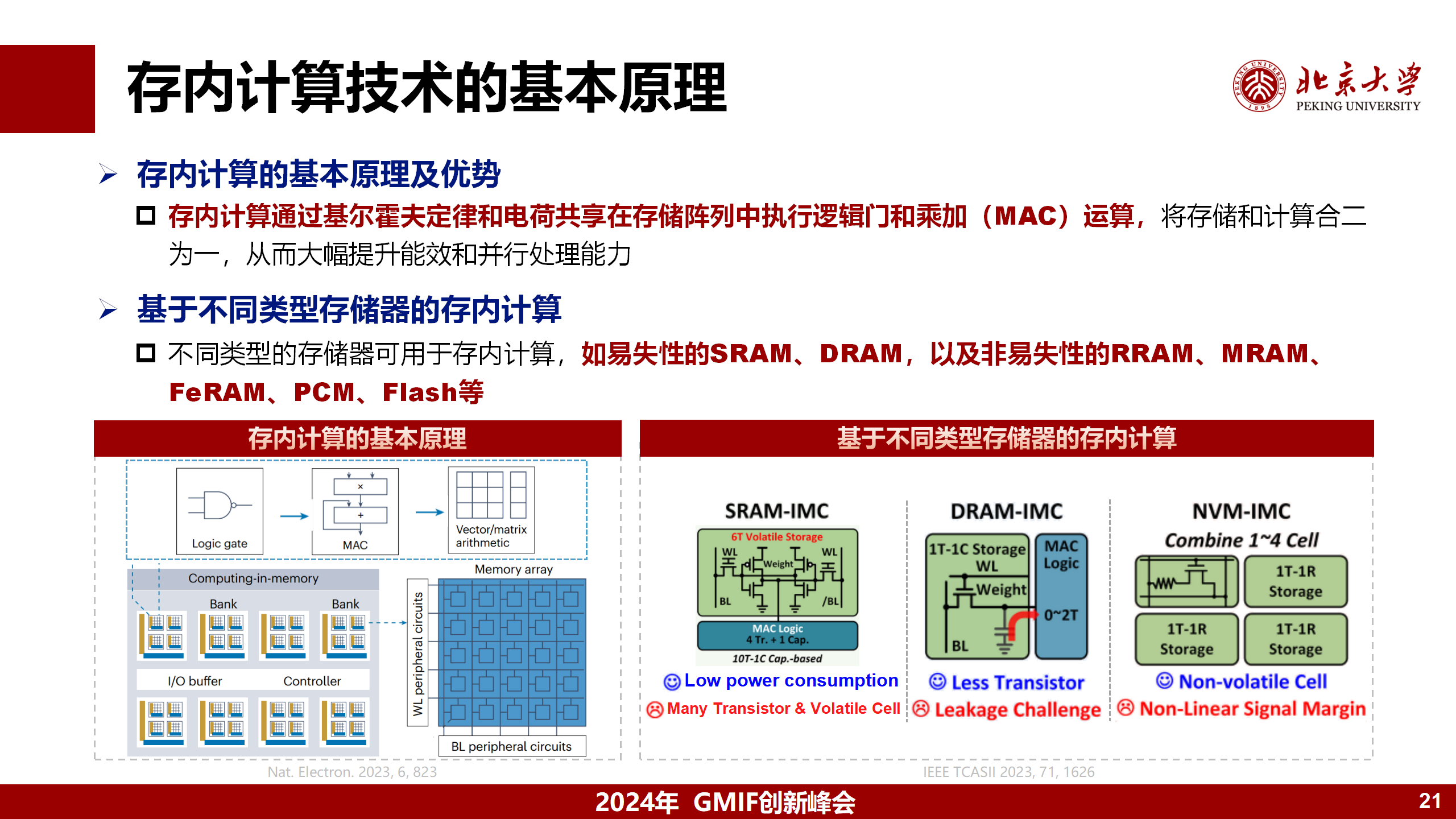

蔡院长在演讲中详细阐述了存内计算(In-Memory Computing,IMC)这一技术的发展潜力。这项技术通过将计算能力嵌入存储器中,减少了数据在处理器与存储器之间的传输延迟,从而提高系统性能并降低能耗。他指出,存内计算技术的研究目前已取得显著进展,尤其是在基于DRAM、NAND Flash以及新型存储器(如RRAM)的架构等领域具有广阔的应用前景和巨大的价值空间。

蔡院长强调,尽管存内计算当前仍面临一些技术挑战,如非易失性存储器的可靠性问题等,但通过持续不断的研究创新,存内计算有望成为未来AI计算领域的主导技术。这种技术不仅能够加速AI推理,还能够为边缘计算和端侧计算提供高效的解决方案。

多存储器异构架构:AI计算的未来

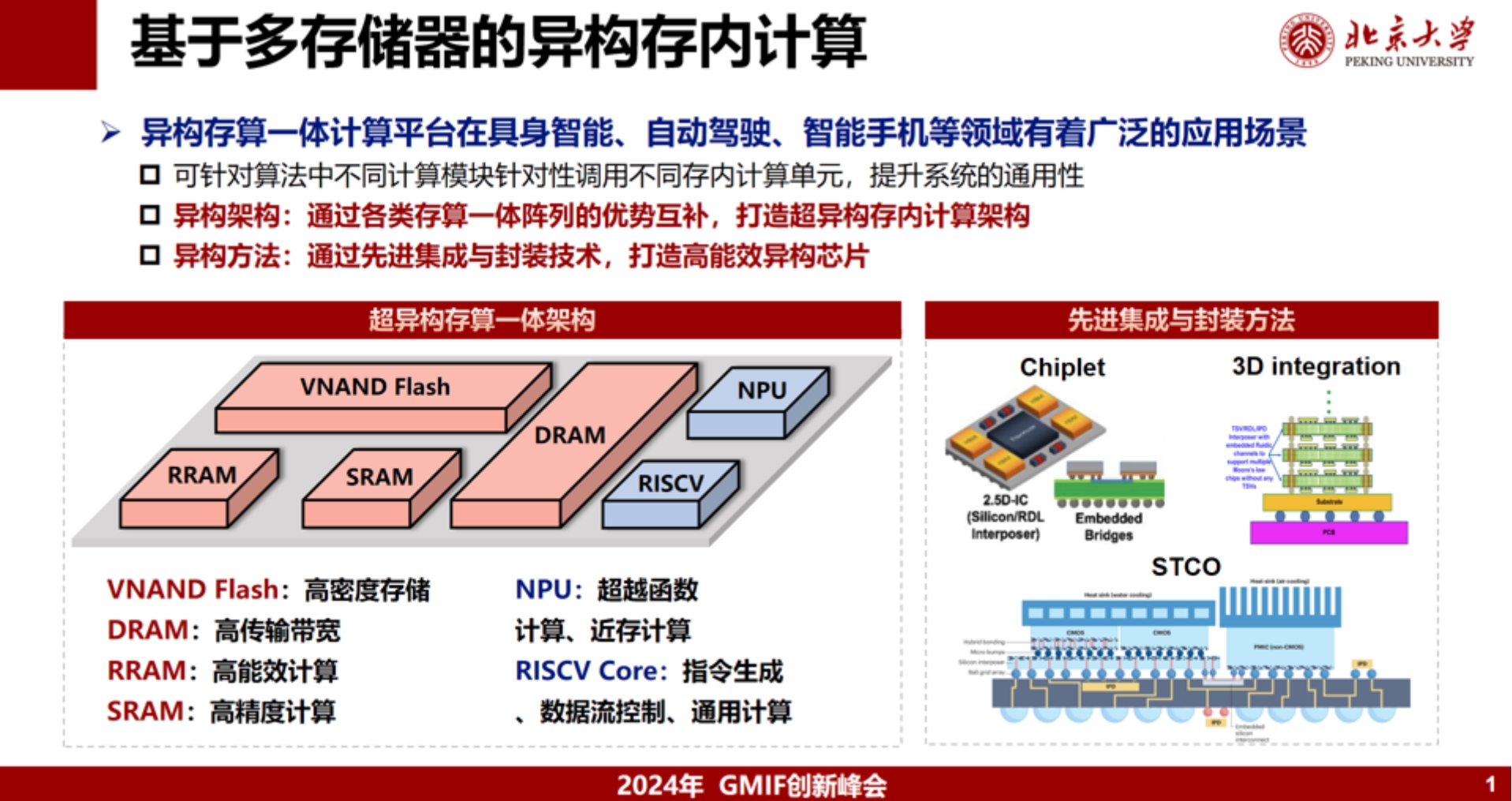

随着AI应用场景趋向多元化发展,单一存储器类型已经难以满足所有计算任务的需求。蔡院长认为,未来的存储架构将向多存储器异构化发展,不同存储器类型如DRAM、NAND、新型存储器等将通过先进封装等技术手段进行协同工作,以应对不同场景下的AI计算需求。

他特别提到,在高带宽和大容量的存储需求下,高性能存储器如HBM的应用已成为未来行业发展趋势。然而,单靠HBM并不足以满足所有AI计算需求,特别是在低功耗、低成本的场景下,还需要通过减少访存频率、优化系统结构等来进一步提升整体能效。

新型存储器的未来展望

同时,蔡院长还提到,未来存储器技术的突破将不仅仅局限于硬件升级本身,引入新的计算范式如类脑计算、量子计算、光子计算等也将成为AI时代存储技术创新的前沿方向。通过采用新的信息编码方式,这些技术有望显著提升AI计算的效率和能效。

存储器与AI的融合:推动行业变革

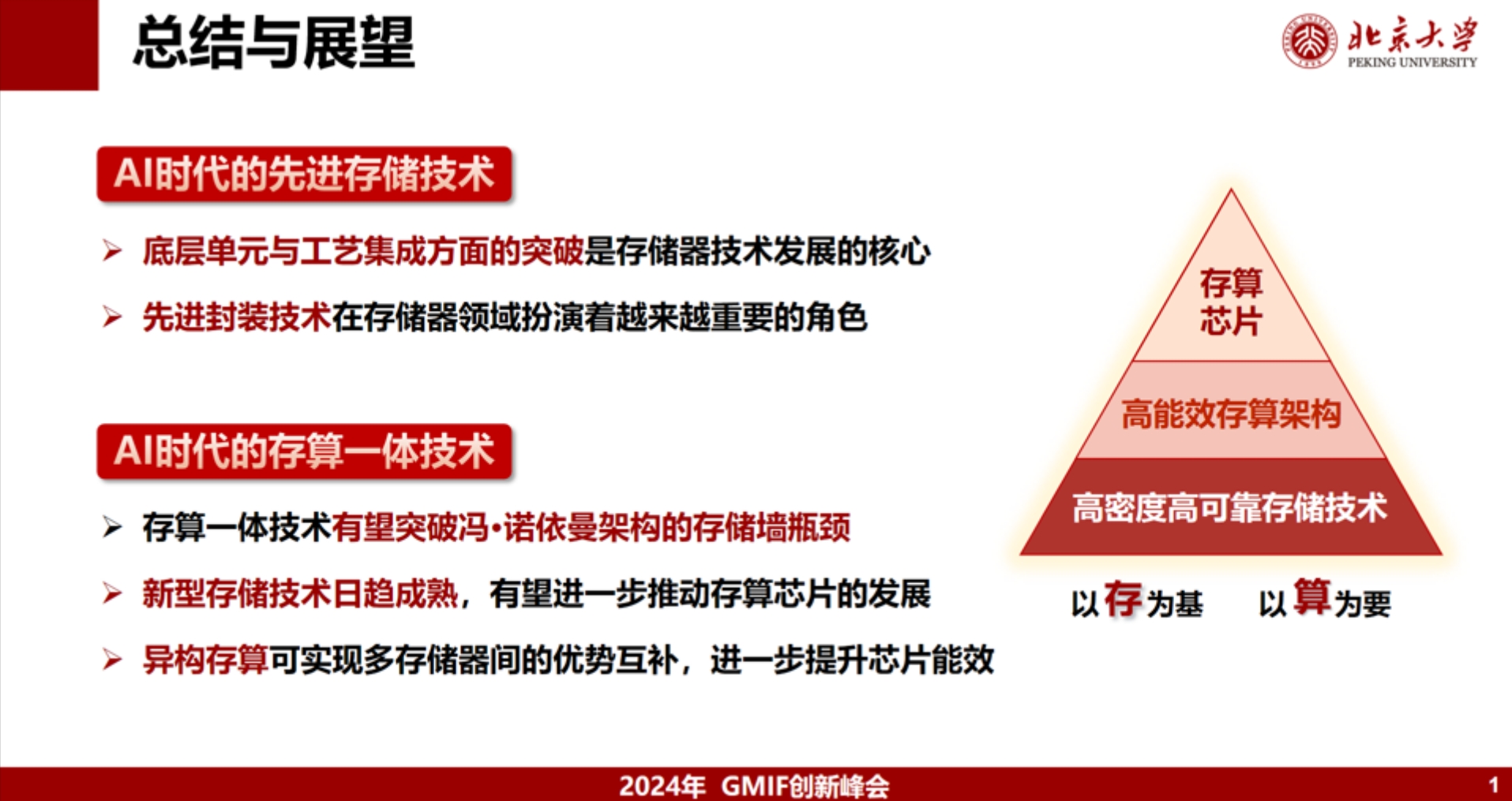

在演讲的最后,蔡院长强调,AI时代的存储器技术发展不仅需要突破容量和速度的限制,更需要在能耗和算力上取得进展。存内计算技术、多存储器异构架构以及新型存储器的应用,将为未来AI计算的发展提供强有力的支持。他呼吁学术界与产业界携手合作,共同推动存储技术的创新与进步,更好应对智能时代的风险和挑战。

结语

随着AI技术的快速发展,存储器和计算架构的创新已成为信息技术领域的重要课题。未来,多存储器异构架构和存内计算技术的推广应用,将为大规模AI计算提供更加高效的解决方案。而北大集成电路学院在这一领域的持续探索和研究,也将为推动全球存储技术的革新贡献力量,推动集成电路行业走向一个更加智能、更加高效的未来。