背景

InternVL2是由上海人工智能实验室OpenGVLab发布的一款多模态大模型,中文名称为“书生·万象”。该模型在多学科问答(MMMU)等任务上表现出色,并且具备处理多种模态数据的能力。

本文将通过走马观花的方式,基于InternVL2家族中最小的InternVL2-1B模型来介绍其技术特点。同时也将分享基于爱芯元智的AX650N、AX630C两款端侧AI芯片适配InternVL2-1B的基本操作方法,向业界对端侧多模态大模型部署的开发者提供一种新的思路,促进社区对端侧多模态大模型的探索。

InternVL2-1B

github地址:

https://github.com/OpenGVLab/InternVL

官方博客:InternVL2

在线DEMO:

https://internvl.opengvlab.com/

AX650N

爱芯元智第三代高能效比智能视觉芯片AX650N。集成了八核Cortex-A55 CPU,高能效比NPU,支持8K@30fps的ISP,以及H.264、H.265编解码的 VPU。接口方面,AX650N支持64bit LPDDR4x,多路MIPI输入,千兆Ethernet、USB、以及HDMI 2.0b输出,并支持32路1080p@30fps解码内置高算力和超强编解码能力,满足行业对高性能边缘智能计算的需求。通过内置多种深度学习算法,实现视觉结构化、行为分析、状态检测等应用,高效率支持基于 Transformer结构的视觉大模型和语言类大模型。提供丰富的开发文档,方便用户进行二次开发。

产品规格书:

https://www.axera-tech.com/filespath/files/20240202142256.pdf

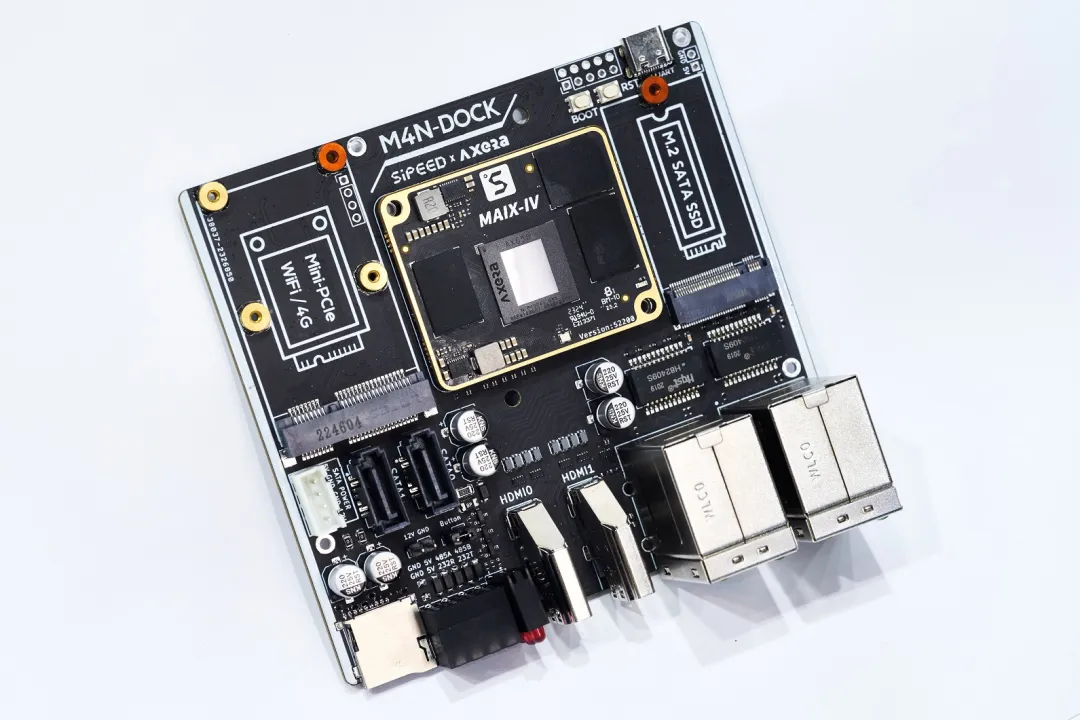

社区开发板:

AX630C

爱芯元智第四代智能视觉芯片AX630C,该芯片集成新一代智眸4.0AI-ISP,最高支持4K@30fps实时真黑光,同时集成新一代通元4.0高性能、高能效比NPU引擎,使得产品在低功耗、高画质、智能处理和分析等方面行业领先。提供稳定易用的SDK软件开发包,方便用户低成本评估、二次开发和快速量产。帮助用户在智能家居应用和其他AIoT项目中发挥更大的价值。

产品规格书:

https://www.axera-tech.com/filespath/files/20231113181459.pdf

AX630C应该是目前能效比&性价比&能跑LLM/VLM的最佳的端侧AI芯片了,因此有客户基于AX630C出品了LLM Module,欢迎关注/试用。

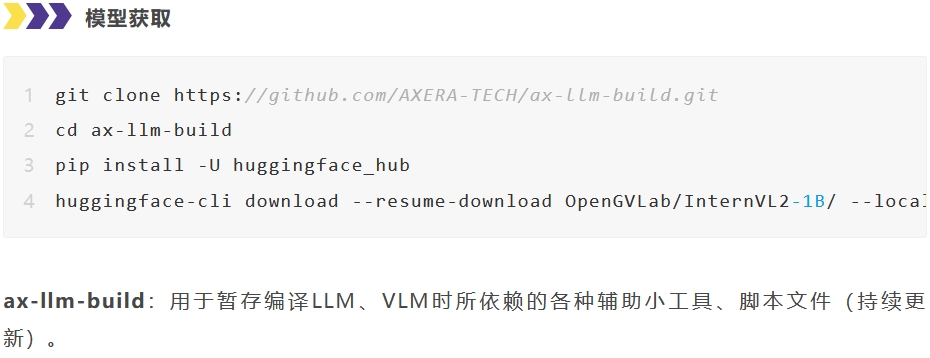

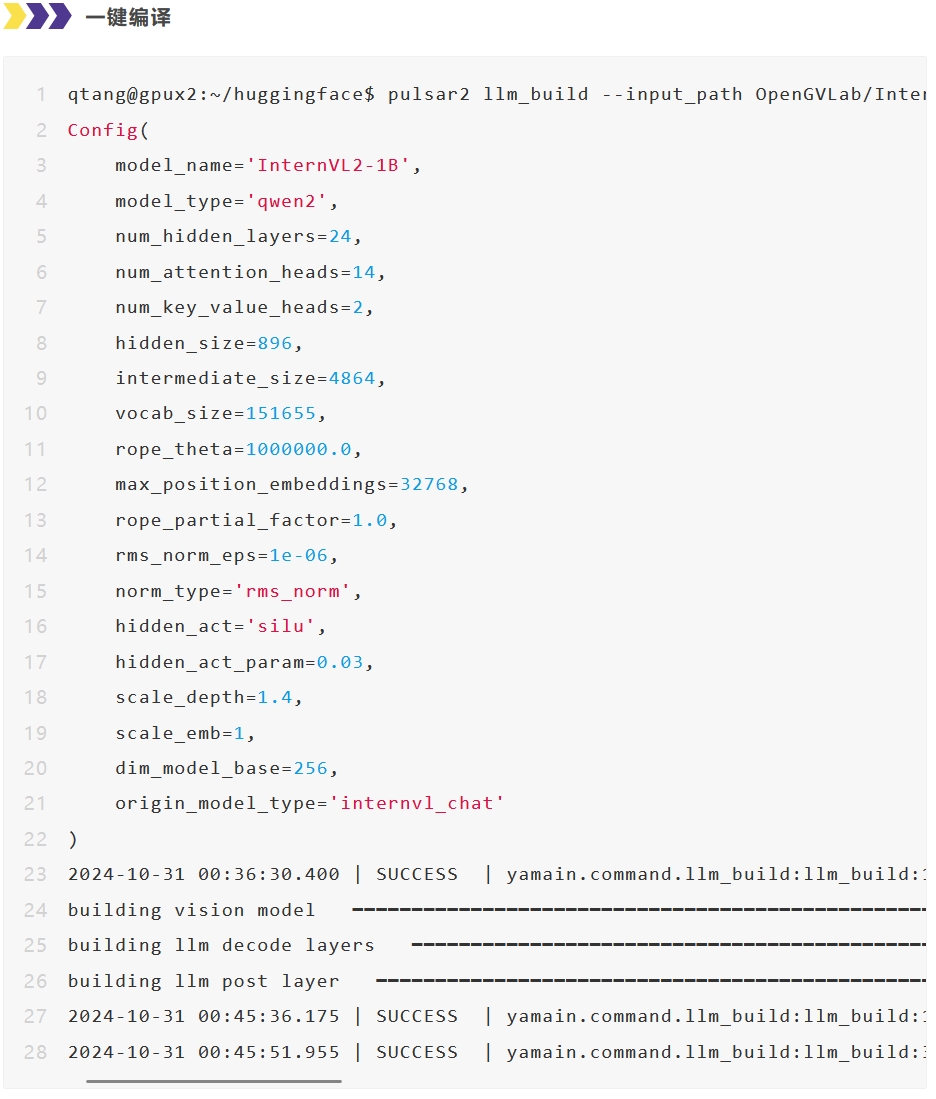

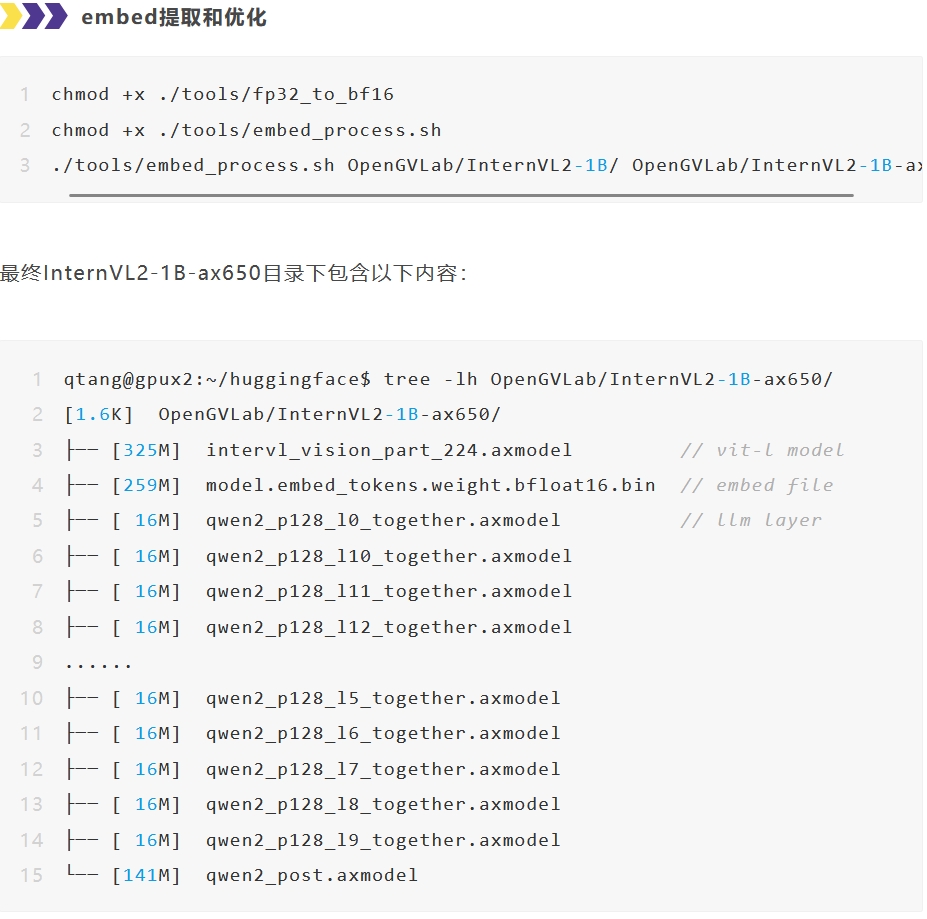

模型转换

经常在AI芯片上部署AI算法模型的同学都知道,想要把模型部署到芯片上的NPU中运行,都需要使用芯片原厂提供的NPU工具链,这里我们使用的是Pulsar2。

Pulsar2是爱芯元智的新一代NPU工具链,包含模型转换、离线量化、模型编译、异构调度四合一超强功能,进一步强化了网络模型高效部署的需求。在针对第三代、第四代NPU架构进行了深度定制优化的同时,也扩展了算子&模型支持的能力及范围,对Transformer结构的网络也有较好的支持。

从Pulsar2 3.2版本开始,已经增加了大语言模型编译的功能,隐藏在pulsar2 llm_build的子命令中。

具体使用方式请参考:

https://pulsar2-docs.readthedocs.io/zh-cn/latest/appendix/build_llm.html

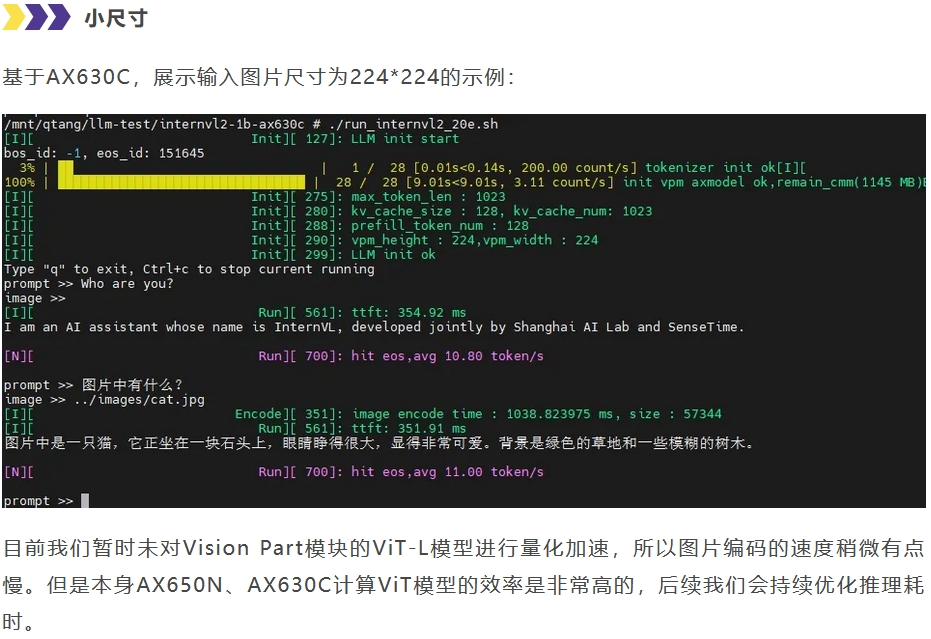

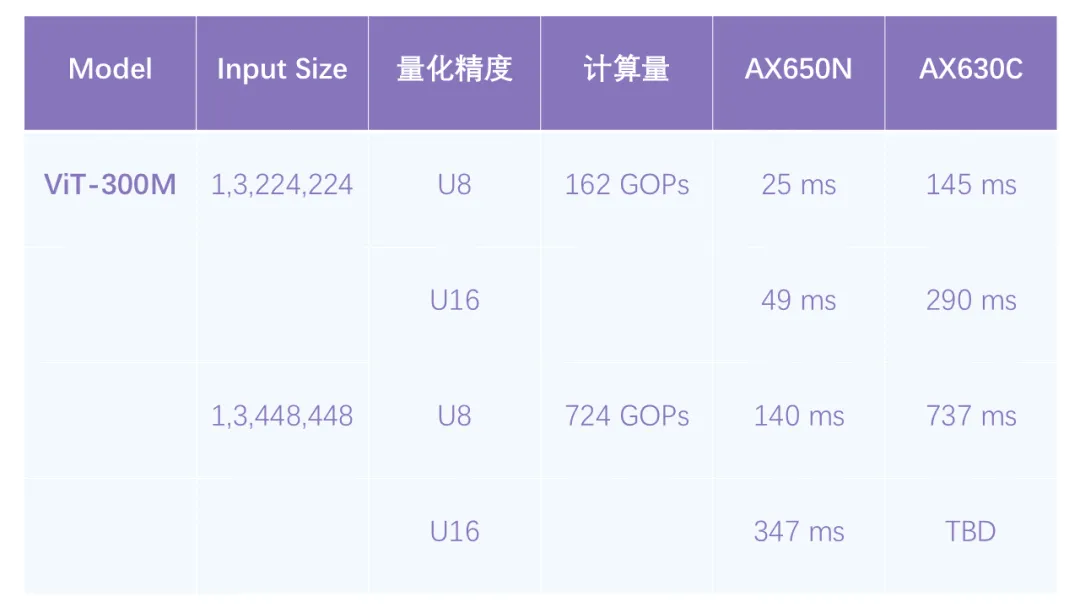

上板示例

结束语

虽然我们只尝试了最小的InternVL2-1B部署,但能在原本定位于低成本家用摄像头芯片(AX630C)上本地流畅运行VLM已经是一个重大突破,例如无需联网(包括蓝牙)的智能眼镜、智能的“拍立得”、以及各种有趣的穿戴设备。

随着大语言模型小型化的快速发展,越来越多有趣的多模态AI应用已经从云端服务迁移到端侧设备。我们会紧跟行业最新动态,适配更多的端侧大模型,欢迎大家持续关注。

更多模型请查看:

https://github.com/AXERA-TECH/ax-llm