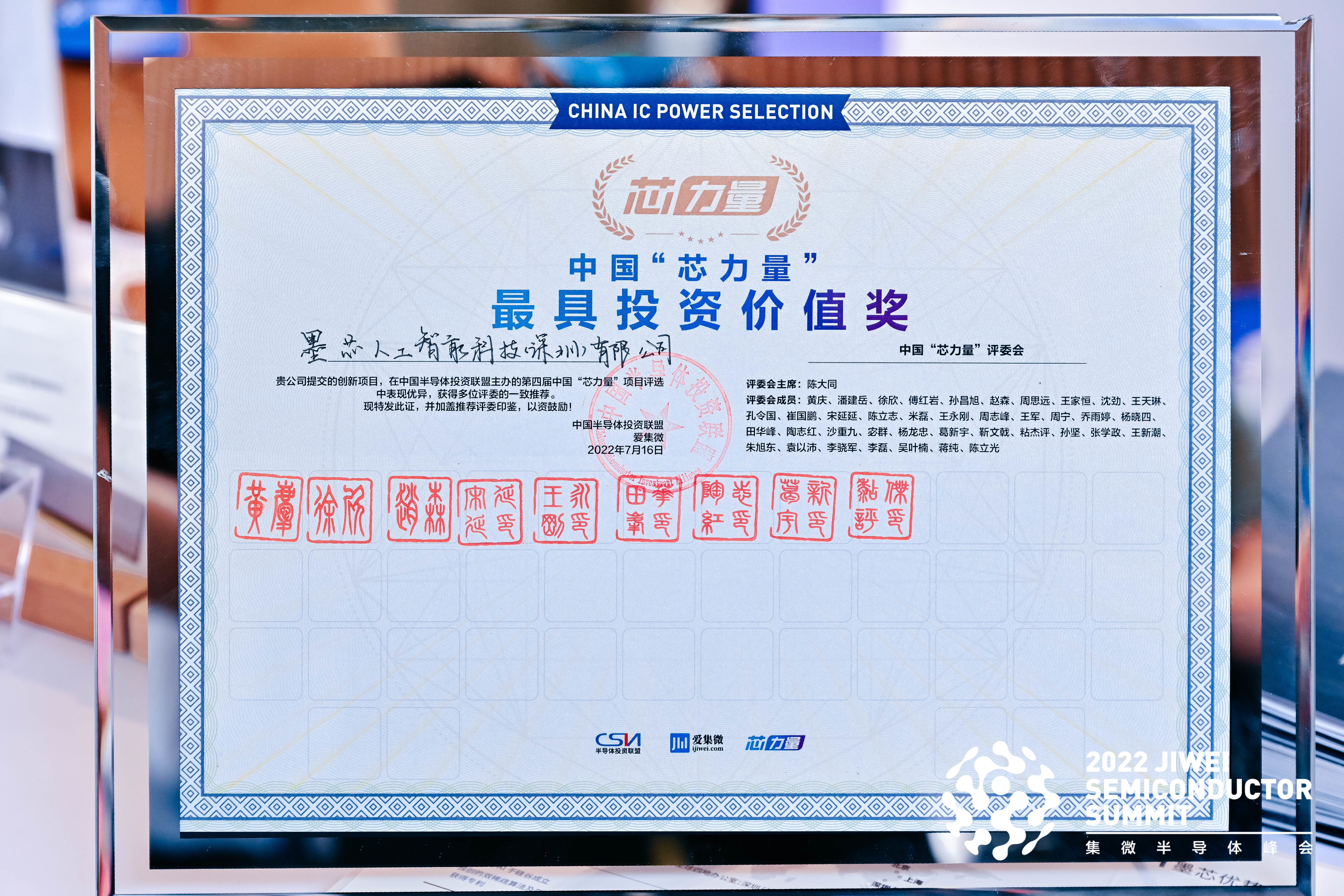

2022年7月15日,墨芯人工智能参展厦门半导体峰会,首席科学家严恩勖发表演讲,展示墨芯如何用稀疏化推动AI计算前沿和最新的产业进展。16日墨芯获评“最具投资价值奖”。

上图:墨芯联合创始人兼工程VP芦勇代表墨芯领奖

中图: 国家大基金总裁丁文武与芦勇台上合影

下图:中国“芯力量”|“最具投资价值奖”奖杯

集微峰会被誉为“半导体业风向标”,设特色“芯力量”展区和EDA展区。墨芯位于“芯力量”展区核心位置——76号展台。

墨芯作为稀疏化计算引领者,致力于提供云端和终端AI计算平台和服务,打造软硬协同的新一代智能计算平台。团队携首个芯片Antoum®和人工智能推理计算卡S4参展。

墨芯人工智能S4计算卡基于墨芯首颗芯片Antoum®,是全球首款高达32倍稀疏率的AI计算卡。S4专注于数据中心AI推理应用,可广泛应用于互联网、运营商、金融、制造、医疗、交通、能源、生物医药等众多AI推理场景。S4在第三方浪潮服务器上,运行多个主流AI模型,实测性能是国际大厂主流AI推理卡T4的6倍。近年来新兴的NLP模型——T5,曾被称为“全新NLP SOTA预训练模型”,以其高参数量,让许多计算卡“望而却步”。S4在单机单卡环境下就能运行T5-8B模型,算力稳定在190 SPS左右。

值得注意的是,S4运行T5时内存占比只有约7.8%,让人对它能够支持的模型参数具有很大想象空间。相较于当前国际大厂主流推理卡单卡只能支持百亿参数级别的模型,S4计算卡可以支持千亿参数级别的模型。

S4不仅运行大模型性能测试表现优秀,运行其他经典AI模型,如图像分类识别模型ResNet-50、自然语言处理领军模型BERT的性能数据也很亮眼。

下图为S4运行BERT模型在单机单卡环境,不影响精度的前提下,性能达13213 SPS,为国际大厂主流AI推理卡的6倍以上,功耗仅为后者一半。

基于创新稀疏化计算技术的AI推理计算卡S4的亮眼性能吸引业内人士纷纷前来咨询。

峰会首日的另一亮点来自于业内领先公司的现场演讲。

峰会首日的另一亮点来自于业内领先公司的现场演讲。

墨芯人工智能首席科学家严恩勖发表了《AI步入大模型时代,稀疏化是AI计算的未来》演讲。

自2018年BERT大模型问世以来,AI进入大模型时代。目前大模型的热门方向包括NLP、CV、多模态等,目前以GPT-3、Switch Transformer为代表的大模型已经进入商业化部署。尤其是多模态AI大模型推动AI从弱人工智能向通用人工智能演进。

但是大模型由于参数量巨大,对算力的需求前所未有,而现有的硬件算力升级效率放缓,以至于很难满足大模型的算力需求。而墨芯作为稀疏化计算的引领者,试图用稀疏化计算平台来解决这个算力瓶颈。不仅如此,还能解决大模型带来的高能耗、高成本的问题。

稀疏化计算是指在原有AI计算的大量矩阵运算中,将无效元素剔除,让神经网络模型消减冗余,以显著加快计算速度,降低计算成本。稀疏化计算解决方案具有四个核心价值:高算力,低功耗,高精度,高性价比。

稀疏化如何做到?严恩勖总结为以下2点:

1、软硬协同设计:业界大部分的公司要么是侧重硬件公司,要么是侧重软件算法公司,业界要么是选择配合现有的硬件设计一些次优化的算法,或者是配合当前算法设计一些次优化的硬件,这些都无法带来数量级算力提升。墨芯采用软硬协同设计,因为唯有这样,才能提高数量级算力提升。

2、独创稀疏化算法:双稀疏算法是指神经网络的权重稀疏化+激活稀疏化。使用双稀疏化允许开发人员在使用相同的内存、计算量和能耗的条件下,处理更大的矩阵乘积。双稀疏化算法具有高算力、低功耗、高能效比等优点。

S4计算卡的超高性能让现场观众印象深刻,严恩勖关于稀疏化对AI计算的创新意义的阐述引发了现场观众对墨芯的浓厚兴趣,与会者对他的演讲反响热烈。他的演讲刚一结束,与会者纷纷上前咨询。

会后,他接受了集微网专访,他说:“厦门半导体峰会聚集了业内最好的公司和平台,而墨芯作为稀疏化计算引领者,希望在这里找到志同道合的伙伴共创稀疏化生态。”