集微网旧金山报道(文/张轶群)在AI浪潮席卷全球,且将人工智能列为第一战略重点后,AMD在AI的技术创新高地继续保持攻势,并对英伟达一家独大的市场格局造成强烈冲击。

北京时间6月14日凌晨,AMD在美国旧金山举办的“数据中心和人工智能技术首映式”活动上,正式发布了MI300系列在内的一系列数据中心及人工智能相关技术产品。AMD董事长兼CEO苏姿丰博士(Lisa Su)表示,AI存在大量的市场机会,而最大的机遇来自于数据中心。

Bergamo:3D V-Cache加持 为云工作负载而生

去年,AMD推出了领先的3D V-Cache技术,并基于此打造了第三代AMD EPYC Milan-X系列处理器。

此后,3D V-Cache成为EPYC处理器的标配。今日,AMD宣布推出采用3D V-Cache技术更新后的第四代EPYC处理器。

针对不同场景以及负载需求,第四代EPYC处理器包括面向通用计算领域的“Genoa”、面向云原生计算领域的“Bergamo”、面向技术计算领域的“Genoa-X”以及面向电信/边缘计算的“Siena”,前三项产品已经实现出货,Siena将于今年下半年出货。

其中,“Bergamo”是业界首款x86云原生CPU。它基于特别定制的Zen 4c微架构,保持了与Zen 4微架构基本相同的功能集,同时将内核尺寸要求减半。因此,Zen4c相当于Zen4核心的增强版本,针对功耗和性能进行了优化。同时,重新设计了L3Cache的层次结构,从而获得更大的吞吐量。

Bergamo与Genoa不同,采用8个计算芯片,每个16核,但中央用的是与Genoa相同的6nm IO die, Bergamo有128个“Zen 4c”内核,能够为在云端运行的应用程序带来最大的vCPU密度和行业领先的性能。在各种云原生应用程序中,Bergamo提供的性能提高2.6倍。优势在于具有灵活的扩展性,能够实现核心数以及功耗上的平衡。

行业分析指出,Bergamo作为一个云原生SoC,在某种程度上是对安培、亚马逊、谷歌和微软等新兴的基于Arm的数据中心级SoC的回应。Bergamo在设计上基于多种因素,包括效率、功耗、芯片尺寸和低总拥有成本(TCO),而不是以提供最大的每核性能为目标。

苏姿丰表示,自2017年推出EPYC以来,EPYC已经成为云计算的行业标准。鉴于在各种工作负载中的领先性能和TCO,每个主要的云提供商都为其内部工作负载以及面向客户的实例部署了EPYC。目前,全球有超过640个EPYC实例,另有200个将在今年年底推出,而且,EPYC在行业中的渗透率也在增长。

会上,微软宣布全面推出基于第四代EPYC处理器以及3D V-Cache技术的Azure HBv4和HX实例。与上一代HBv3相比,最新的实例提供了高达5倍的性能提升。亚马逊也展示了基于新一代AMD EPYC处理器的EC2 M7a实例,具有50%计算性能的提升,并能够支持更广泛的工作负载。

MI300X:最强生成式AI加速器 单GPU跑大模型

今日,此前备受行业关注的神秘芯片MI300揭开面纱。实际上,AMD Instinct MI300系列包括两款产品:MI300X与MI300A。

据苏姿丰介绍,MI300X是目前最先进的生成AI加速器。基于第三代CDNA架构,MI300X支持高达192GB的HBM3内存(英伟达的H100只有80GB),HBM内存带宽高达5.2TB/s(是英伟达H100的1.6倍),Infinity Fabric总线带宽为896GB/s,晶体管数量达到1530亿个。

MI300X相当于专为生成式AI设计的GPU,借助性能上的优势,可以在单个GPU上适配大型语言模型,例如400亿个参数模型Falcon-40B,苏姿丰还在现场利用MI300X演示了内容生成,撰写了一篇关于旧金山的诗歌。

MI300A则是业界首款“CPU+GPU+HBM显存”一体化的数据中心芯片,同时也是全球首款面向高性能和AI工作负载的APU加速器。MI300A具备24个高性能Zen4 CPU核心,CPU和GPU均为5nm制程,I/O die采用6nm,包含128G HBM内存,晶体管数量达到1460亿个、多于英伟达H100的800亿个。

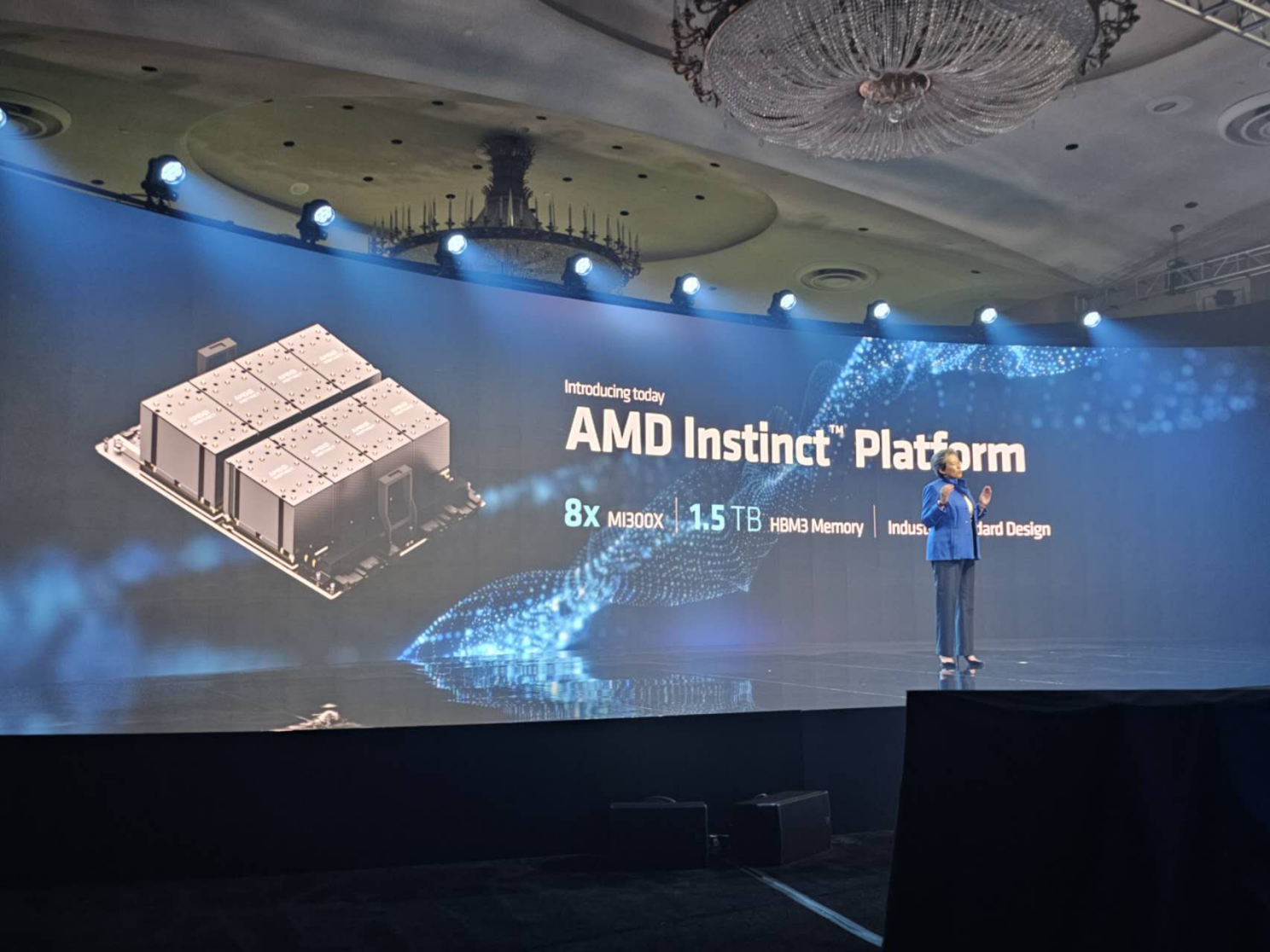

此外,AMD还推出了由8个MI300X整合在一起的Instinct平台,具有高达1.5TB HBM3内存。

此外,AMD还推出了由8个MI300X整合在一起的Instinct平台,具有高达1.5TB HBM3内存。

作为目前AMD AI领域最强芯片,MI300X被视为是对标英伟达H100的产品。有分析指出,从性能上MI300X性能显著超越H100,在部分精度上的性能优势高达30%甚至更多。而对于MI300A,凭借CPU+GPU的能力,产品组合性能更高、同时具有成本优势。AMD在收购赛灵思之后,在加速卡领域的定制化服务大幅领先英伟达,能够协助云厂商在特定算法模块上进行训练,上述因素都将为MI300系列带来竞争优势。

据苏姿丰介绍,MI300A已经向客户送样,MI300X将于今年Q3送样,两款产品预计今年Q4规模量产。

AMD强攻AI:叫板英伟达 欲扭转市场格局

如今,AI技术带来的热潮,使得越来越多的公司投入其中。AMD视AI为第一战略,全力押注,十分看好AI市场的广泛前景。

如今,AI技术带来的热潮,使得越来越多的公司投入其中。AMD视AI为第一战略,全力押注,十分看好AI市场的广泛前景。

今天的会议现场,苏姿丰给出了AMD对于AI市场的判断。AMD预计,来自CPU、FPGA以及其他AI数据中心业务将推动市场规模从2023年的300亿美元增加到2027年的1500亿美元,年均复合增长率超过50%。

外界也对AMD此次芯片发布给予较高期望。6月12日,AMD盘前涨近3%,股价创2022年1月18日以来新高。

一些分析机构的研判认为,MI300X性能强大,是对标英伟达高端加速卡的有力竞品。相较H100,MI300X在晶体管数量和显存容量上亦大幅领先。随着MI300X芯片在下半年的量产发布,AMD有望与英伟达在AI加速卡市场展开直接竞争。而随着下游应用端的高速发展,使得微软、谷歌、Meta等众多海外巨头争相增加算力储备,算力芯片需求高度旺盛之下,英伟达一家独大的市场格局或将迎来转变。

正因如此,资本市场对于AMD给予更多积极的预期。部分分析观点认为,AMD2024年AI相关营收有望达到4亿美元,最高甚至可能达到12亿美元——是此前预期的12倍之多。昨日,数家美国投行还相继大幅上调了对AMD的目标价,最高上调50美元之多。(校对/李映)

正因如此,资本市场对于AMD给予更多积极的预期。部分分析观点认为,AMD2024年AI相关营收有望达到4亿美元,最高甚至可能达到12亿美元——是此前预期的12倍之多。昨日,数家美国投行还相继大幅上调了对AMD的目标价,最高上调50美元之多。(校对/李映)