据Business Korea报道,由于参与云服务器业务的全球科技公司对人工智能芯片的需求不断升级,对人工智能芯片至关重要的高性能存储半导体的需求正在经历爆炸性增长。因此,人们提供这些存储芯片的公司未来的业务前景抱有很高的期望。重点是三星电子等企业将于明年推出的与高带宽内存(HBM)芯片相关的下一代产品。

市场研究公司TrendForce最近8月1日进行分析认为,随着北美和中国的云服务器提供商(CSP)对AI芯片相关技术的进一步验证,AI加速芯片市场的竞争将会加剧,有助于推动AI加速芯片市场的竞争。HBM市场前景乐观。

三星等目前在人工智能时代处于全球市场的前沿,其中HBM技术因其在DRAM中的应用而受到广泛关注。HBM是一种高性能产品,可垂直堆叠多个DRAM芯片,并在专为AI处理而设计的图形处理单元 (GPU) 等设备中找到应用。

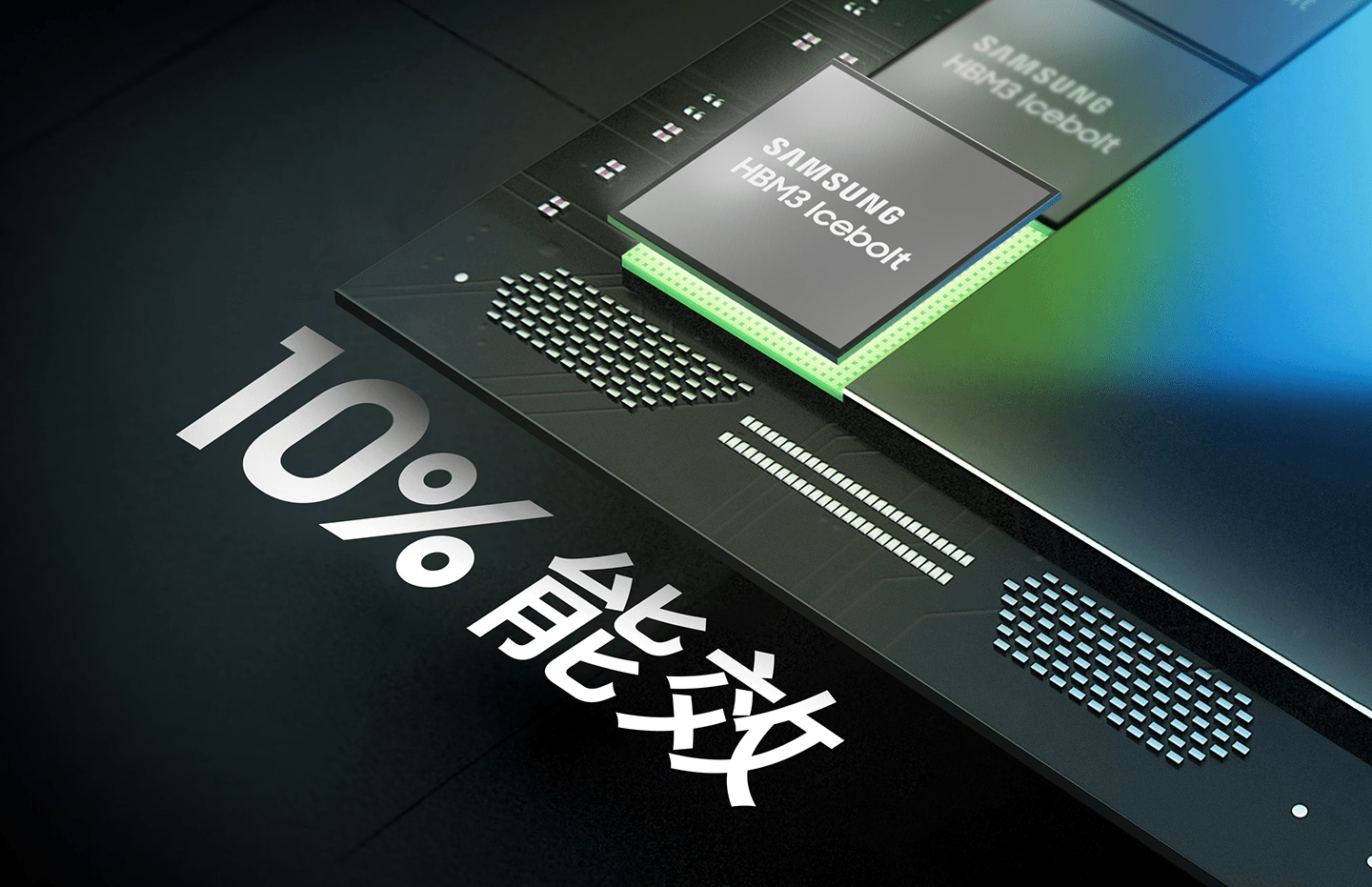

HBM 正在开发多代,即第一代(HBM)、第二代(HBM2)、第三代(HBM2E)、第四代(HBM3)和第五代(HBM3E)。每一代新芯片的带宽都会得到增强,从而实现更快的速度和更高的内存容量,使HBM成为人工智能相关任务的首选。

据TrendForce统计,谷歌、亚马逊、微软等涉足云服务器业务的全球科技巨头越来越多地采用HBM,其中HBM2E是其中的突出选择。值得注意的是,广泛应用于人工智能相关任务的 英伟达 的“A100”和“A800”以及 AMD 的“MI200”芯片均采用HBM2E。三星等企业目前都在向全球客户供应HBM2E,并在市场上占据主导地位。

微软在当地时间7月28日发布的年度报告中强调了其云业务中的一个新的风险因素,首次提到GPU短缺,并强调扩大AI GPU市场的必要性。微软表示,“数据中心的运营依赖于可预测的土地、能源、网络供应和服务器,包括图形处理单元(GPU)。”

TrendForce预计,三星等企业的下一代产品,包括HBM3和HBM3E,将在明年主导相关芯片市场。目前,SK海力士是HBM3的全球唯一生产商,该产品被集成到英伟达领先的AI芯片“H100”中。

然而,随着英伟达计划在2025年推出下一代“GB100”芯片的消息传出,人们对国内企业HBM3供应的担忧日益加剧。为了满足需求,三星等企业预计将于明年第一季度发布HBM3E样品,并于2024年下半年开始量产。HBM3E采用10纳米范围内先进的第五代工艺技术。美国半导体公司美光近日宣布有意独立开发HBM3E,宣告进军三星等企业主导的HBM市场,引发业界关注。不过,业界认为,美光在这一领域的技术能力想要追上三星等企业并不容易。

此外,今年下半年以来成为服务器市场主力的核心内存DDR5(Double Data Rate 5)近期价格出现反弹,增强了三星等企业的“盈利扭亏为盈”的预期。据TrendForce统计,7月份DDR5 8GB产品平均固定成交价格为15.30美元,较上月的14.84美元上涨3.13%。 DDR5 16GB产品的价格涨幅更高,达到37.9%。 因此,DDR5 8GB的价格自2021年12月以来一直从44.70美元持续下跌,但最近在时隔1年零6个月后出现反弹迹象。(校对/周宇哲)