英伟达在2023年全球超算大会(SC2023)上推出了一款最新的AI芯片H200,用于AI大模型的训练。

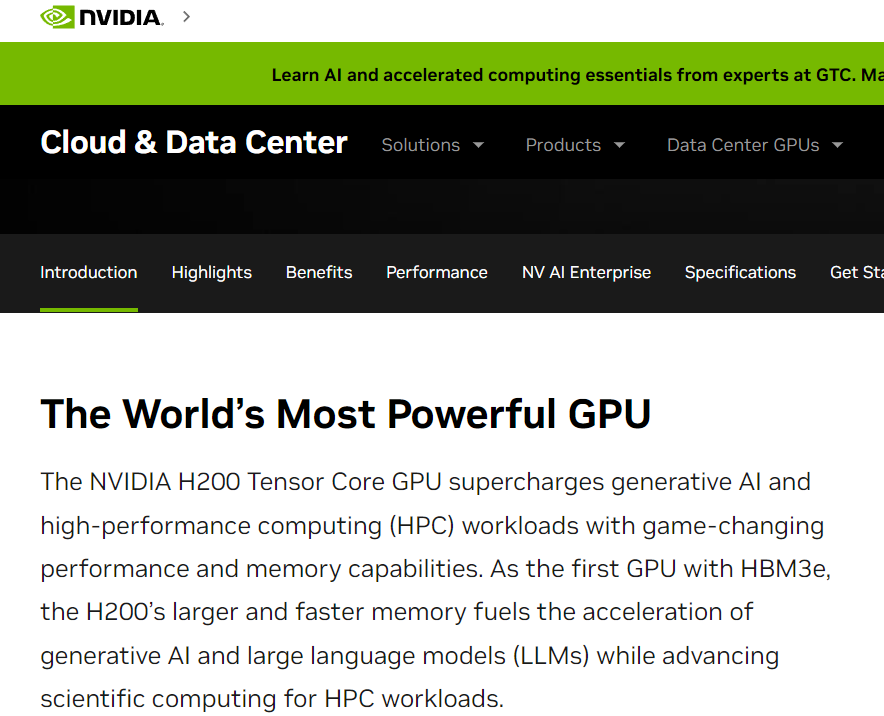

英伟达对其火爆的H100 人工智能GPU进行了重磅升级,最新款高端芯片名为H200,基于英伟达的“Hopper”架构,是英伟达第一款使用HBM3e高带宽内存的GPU,这种内存速度更快、容量更大,因此更适合处理大型数据集,而这是开发大型语言模型所必需的。在用于推理或生成问题答案时,性能较H100提高60%至90%。

英伟达公司表示,基于HBM3e,H200以每秒4.8 TB的速度提供141GB的内存,与A100相比,容量几乎是其两倍、带宽增加了2.4倍。

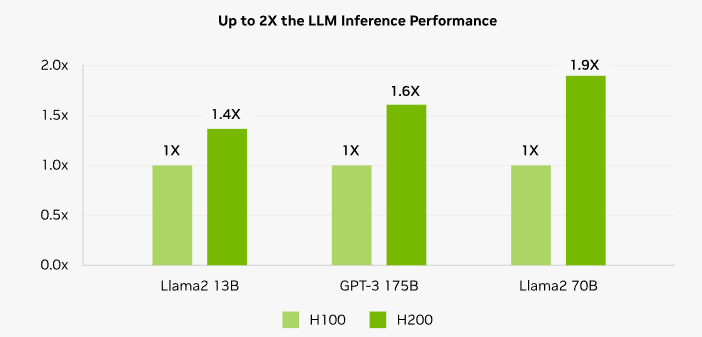

在备受瞩目的人工智能领域,英伟达提到,H200将带来进一步的性能飞跃。在Llama 2(700亿参数的LLM)上的推理速度比H100快了一倍。未来的软件更新预计会给H200带来额外的性能领先优势和改进。

H200将在具有四路和八路配置的英伟达HGX H200服务器主板中提供,并与HGX H100系统的硬件和软件兼容。

据悉,大型计算机制造商和云服务提供商预计将于明年第二季度开始使用H200。亚马逊的AWS、Alphabet公司的谷歌云、微软Azure和甲骨文的云基础设施,都承诺从明年开始使用这款新芯片。

英伟达表示,通过推出新产品,公司希望跟上用于创建人工智能模型和服务的数据集规模的增长。增强的内存能力将使H200在向软件提供数据的过程中更快速,这个过程有助于训练人工智能执行识别图像和语音等任务。

过去,英伟达通常两年更新一次芯片架构,最新的芯片架构是Hopper。不过上个月,英伟达对投资者表示,由于市场对其GPU需求旺盛,该公司将从每两年发布一次新架构转向每一年就发布一次新架构。 (校对/赵碧莹)