1、美国《芯片法案》为惠普半导体技术项目拨款5000万美元

2、日本官员争取促成熊本三厂 台积电:先做好两个厂再考虑扩充

3、美光斥资81亿新台币收购友达台南厂房等资产

4、英伟达公布Blackwell架构更多细节:引领AI与超级计算的新纪元

5、我们距离真正的开源人工智能还有很长的路要走

1、美国《芯片法案》为惠普半导体技术项目拨款5000万美元

美国商务部表示,计划向惠普拨款5000万美元,以支持该公司在俄勒冈州现有工厂的扩建和现代化,这将推动关键半导体技术的发展。

美国商务部表示,拟议的资金将支持服务于生命科学仪器和人工智能(AI)应用及其它项目中使用的技术硬件。

美国国会于2022年8月批准了《芯片法案》,这项计划包括390亿美元的半导体制造和相关部件补贴,以及750亿美元政府贷款和25%投资税收抵免(价值约240亿美元)。

这些项目以惠普在微流体和微机电系统方面的专业知识为基础,资金将用于支持制造用于药物发现、单细胞研究和细胞系开发的生命科学实验室设备中至关重要的硅器件。

美国商务部长吉娜·雷蒙多表示,拟向俄勒冈州科瓦利斯市惠普园区提供的5000万美元资金“表明了我们投资半导体供应链每个环节的方式,以及半导体技术对药物研发和关键生命科学设备创新的重要性。”

美国商务部表示,这项技术将推动包括哈佛医学院、美国疾病控制和预防中心和默克公司在内的合作机构的发展。

惠普CEO Enrique Lores表示,这笔资金“为惠普提供了机会,让我们能够现代化和扩大设施,以进一步投资我们的微流体技术。”

美国商务部已公布17家公司的投资意向书,这些公司将获得超过320亿美元的补贴和高达290亿美元的贷款。

美国商务部还计划授予其他重大奖项,包括向韩国三星电子提供64亿美元,以扩大其在得克萨斯州的芯片生产。

英特尔在今年3月获得85亿美元的补贴;台积电获得66亿美元的补贴,用于扩建其美国生产基地;存储芯片制造商美光科技获得61亿美元的补贴,用于资助国内芯片工厂项目。

所有激励奖项尚未最终确定,在美国商务部进行尽职调查后,金额可能会发生变化。

2、日本官员争取促成熊本三厂 台积电:先做好两个厂再考虑扩充

据报道,日本熊本县知事木村敬8月26日率当地官员拜访台积电,积极争取台积电在熊本建设第三座厂。对此台积电表示,维持董事长魏哲家此前的态度,即希望在熊本的两个厂先做好,再考虑未来的扩充。

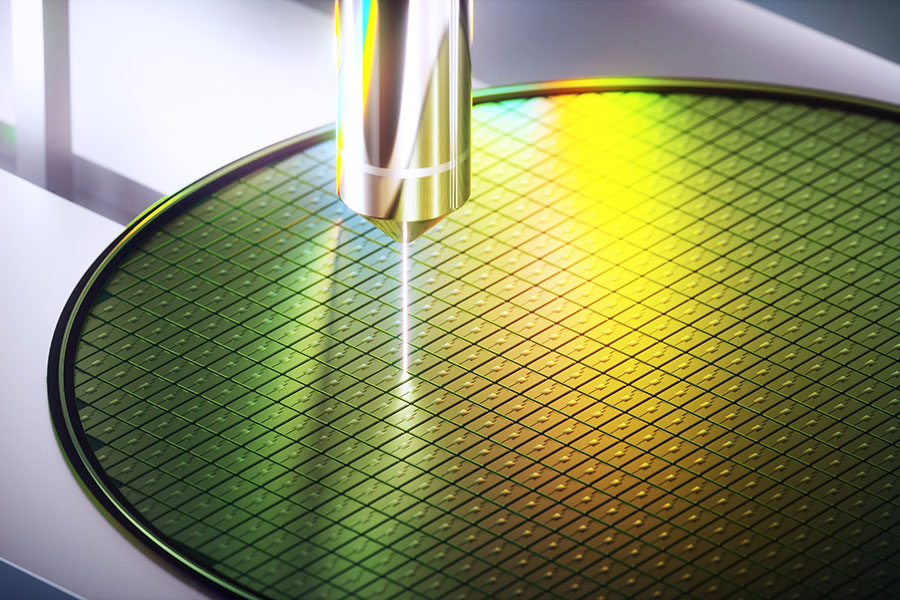

台积电此前宣布在日本熊本兴建两座12英寸晶圆厂。在日本官方大力支持下,台积电熊本一厂资本支出从原计划的约70亿美元提高至86亿美元,预计2024年底开始量产,该厂已于2月底开幕。

台积电熊本二厂方面,6月底有消息称,该厂已开始进行整地工程。预计2024年底开始建设,2027年底开始运营。日本经济产业省指出,台积电熊本二厂位于熊本一厂东侧,用地面积约32.1万平方米,较熊本一厂增加约50%,投资额约2.2万亿日元,而日本政府最高将提供7320亿日元的补贴。

台积电计划熊本两座晶圆厂每月总产能将逾10万片,为汽车、工业、消费类和高性能运算(HPC)相关应用提供40nm、22nm/28nm、12nm/16nm和6nm/7nm制程技术,预计熊本两座晶圆厂总投资超过200亿美元。

有消息传出台积电将在熊本建设第三座厂。木村敬4月就任熊本知事后,8月26日首次到中国台湾,希望促成台积电熊本三厂的规划。台积电表示维持董事长魏哲家此前的态度。

魏哲家此前于台积电股东会后受访时提到,熊本一厂进展非常顺利,并很快宣布兴建二厂,目前策略希望第一与第二个厂做好,再来考虑未来的扩充。

3、美光斥资81亿新台币收购友达台南厂房等资产

友达8月27日发布两则公告,出售台南科技工业区厂房,及子公司友达晶材位于中科后里园区的停车场等建物设施予美光科技,合计两项交易总金额为81亿元新台币,预计处分利益为47.18亿元新台币。

友达公告称,为聚焦运营策略,活化资产及优化财务结构,董事会通过处分台南厂不动产及子公司友达晶材后里部分不动产,均出售予美光。

美光表示,为应对业务需求,美光定期审视并调整全球制造策略,致力为客户提供领先的解决方案,美光在中国台湾的运营满足了人工智能(AI)时代中持续增长的产品需求,并巩固美光的市场领导地位。

美光指出,为维持业界领导地位,已与友达光电签署买卖协议(PSA),收购其位于台南的厂房土地及厂务设备,这家厂房将专注于前段晶圆测试,以支持在台中和桃园厂区持续增加的动态随机存储器(DRAM)生产业务。

此前有消息称,美光在与台积电争夺群创南科四厂中失败后,传出相中友达位于台南科技工业区内、2023年8月关厂的C5D及C6C两座彩色滤光片厂,要做为投入AI服务器用的HBM产线。

4、英伟达公布Blackwell架构更多细节:引领AI与超级计算的新纪元

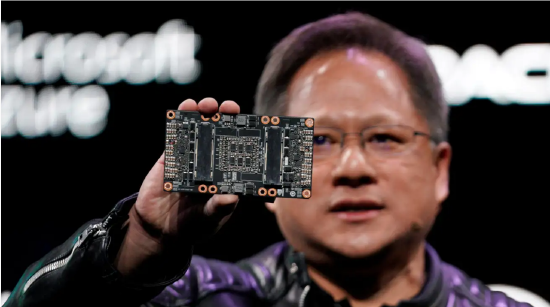

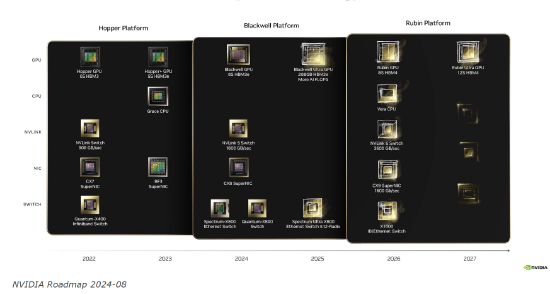

在今日的Hot Chips 2024大会上,英伟达公布了下一代GPU架构Blackwell的更多细节信息,以及未来的产品路线图。

会议期间,英伟达架构总监Ajay Tirumala和Raymond Wong对Blackwell平台进行了初步介绍,并解释了这些技术如何协同工作,在提高能源效率的同时为AI和加速计算性能提供新的标准。

为Blackwell做好准备

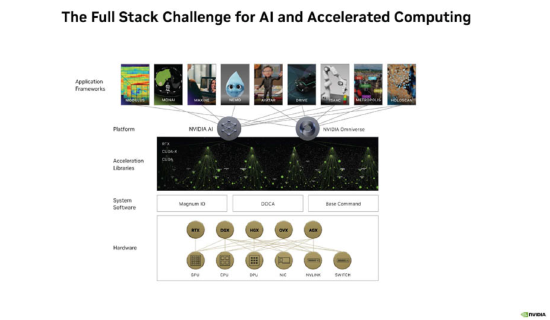

英伟达Blackwell是通用计算全栈矩阵的终极解决方案,由多个英伟达芯片组成,包括Blackwell GPU、Grace CPU、BlueField数据处理单元、ConnectX网络接口卡、NVLink交换机、Spectrum以太网交换机和Quantum InfiniBand交换机。

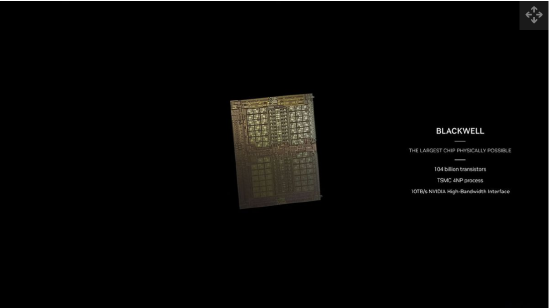

它涵盖了从CPU和GPU计算,到用于互连的不同类型的网络。这是芯片到机架和互连,而不仅仅是GPU。它是有史以来单个GPU所拥有的最强AI计算、内存带宽和互连带宽。通过使用高带宽接口(NV-HBI),可在两个GPU芯片之间提供10TB/s的带宽。

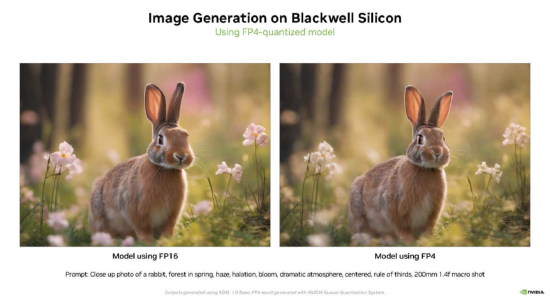

此外,英伟达还引入了新的FP4和FP6精度。降低计算精度是提高性能的一种众所周知的方法。通过英伟达的Quasar量化系统,可以找出哪些方面可以使用较低的精度,从而减少计算和存储。英伟达表示,用于推理的FP4在某些情况下可以接近BF16性能。

NVLink交换机芯片和NVLink交换机托盘(tray)旨在以更低的功耗推送大量数据。英伟达演示了GB200 NVL72和NVL36。其中,NVL72包含36个Grace GPU和72个Blackwell GPU,专为万亿参数AI而设计。GB200 NVL 72作为一个统一系统,对大语言模型(LLM)推理性能提升高达30倍,释放了实时运行数万亿个参数模型的能力。

英伟达表示,随着AI模型尺寸的增加,在多个GPU上拆分工作负载势在必行。而Blackwell足够强大,可以在一个GPU中处理专家模型。

最后,英伟达还展示了2024年至2028年的产品路线图。2026年的1.6T ConnectX-9似乎表明了英伟达对PCIe Gen7的需求,因为PCIe Gen6 x16无法处理1.6T的网络连接。

Blackwell的技术突破

今年3月,英伟达在GTC 2024开发者大会上发布了新的GPU架构Blackwell。Blackwell得名于美国数学家David Blackwell,是英伟达最新一代的AI芯片与超级计算平台。与Grace数据中心CPU、新一代网络芯片等产品一起,面向生成式AI共同组成完整解决方案。

英伟达称,Blackwell拥有6项革命性技术,可支持多达10万亿参数的模型进行AI训练和实时大语言模型(LLM)推理。

1、全球最强大的芯片:Blackwell架构GPU拥有2080亿个晶体管,确保了芯片具有极高的计算能力和复杂性;采用台积电(168.91, -0.16, -0.09%)4纳米工艺制造,提高了芯片的集成度,降低了功耗和发热量;配备192GB的HBM3E显存,极大提升了芯片的数据处理能力和效率。

2、第二代Transformer引擎:结合Blackwell Tensor Core技术和TensorRT-LLM和NeMo Megatron框架中的英伟达先进动态范围管理算法,Blackwell将通过新的4位浮点AI支持双倍的计算和模型大小推理能力。

3、第五代NVLink:为提高数万亿参数和混合专家AI模型的性能,最新一代英伟达NVLink为每个GPU提供了突破性的1.8TB/s的双向吞吐量,确保最复杂LLM之间多达576个GPU之间的无缝高速通信。

4、RAS引擎:Blackwell支持的GPU包含一个专用引擎,实现可靠性、可用性和服务性。此外,Blackwell架构还增加了芯片级功能,利用基于AI的预防性维护进行诊断和预测可靠性问题。这可以最大限度地延长系统正常运行时间,并提高大规模部署AI的弹性。

5、安全人工智能:先进的机密计算功能可在不影响性能的情况下保护AI模型和客户数据,并支持新的本机接口加密协议,进一步增强了芯片的安全性。

6、解压缩引擎:专用解压缩引擎支持最新格式,加快数据库查询,提供数据分析和数据科学的最高性能。

英伟达CEO黄仁勋称,Blackwell不只是芯片,而是一个全新的平台。它将是英伟达历史上、乃至整个计算机历史上最成功的产品。

Blackwell的市场影响

Blackwell架构的推出受到了全球各大云提供商、服务器制造商以及头部AI企业的青睐,如亚马逊(172.385, -3.12, -1.77%)、谷歌(167.48, -0.45, -0.27%)和微软(410.7, -2.79, -0.67%)等。英伟达表示,Blackwell正在被全球各大云服务提供商采用。同时,AI公司、电信提供商和一系列其他技术企业也有着强劲的需求。

Blackwell的发布预示着AI的又一个突破时刻的到来,一经发布便得到了微软CEO萨蒂亚·纳德拉(Satya Nadella)、Alphabet CEO桑达尔·皮查伊(Sundar Pichai)、亚马逊CEO安迪·贾西(Andy Jassy)、OpenAI CEO萨姆·奥特曼(Sam Altman),以及其他知名科技领袖和名人的支持。

至关重要的是,Blackwell是一个更大的生态系统战略的一部分。黄仁勋称:“Blackwell不仅是系统的核心芯片,它实际上还是一个平台。它基本上就是一个计算机系统。”

Nvidia(127.7399, 1.28, 1.01%)还将使用Blackwell来提升其在软件领域的地位和雄心。领先的AI开发商已经依赖Nvidia的CUDA软件来创建由该公司处理器驱动的应用程序,而高性能Blackwell处理器的吸引力应有助于确保客户继续使用其软件。

该战略甚至延伸得更远。黄仁勋在GTC的一次会议上称:“你可以制造芯片让软件运行得更好,但没有软件你就无法创造一个新的市场。我们的独特之处在于,我相信我们是唯一一家能够创造自己市场的芯片公司。”

随着基于Blackwell架构的GPU GB200的发布,英伟达似乎正在为创建新类别的AI软件应用程序打开大门。反过来,此类软件的推出、扩展和持续发展可能会对其超高端GPU产生更大的需求。

Blackwell的延迟

本月初有报道称,英伟达的下一代Blackwell系列AI芯片因设计缺陷问题被迫推迟发布,这一决定可能对包括Meta、谷歌和微软在内的大客户造成影响。

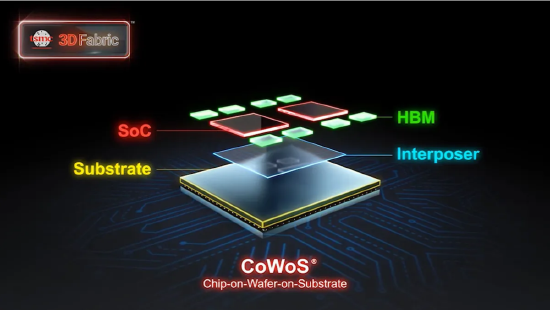

据悉,Blackwell芯片的大规模生产原计划于今年第三季度开始,并于第四季度开始交付。但道,在准备大规模生产时,台积电的工程师发现了设计问题,导致生产受阻。

报道称,由于台积电封装技术CoWoS的复杂性,英伟达将推迟Blackwell GPU的出货时间至2025年第一季度。

瑞银(31.325, 0.20, 0.66%)(UBS)分析师认为,英伟达首批Blackwell芯片最多延迟4~6周出货,即推迟到2025年1月底。为此,许多客户会改而采购交货时间短的H200芯片。

而摩根士丹利(102.57, 0.24, 0.23%)的分析师相对乐观,认为Blackwell芯片的生产仅会暂停约两周,并可在2024年第四季度通过台积电的努力赶上进度。

整体而言,分析师认为有关Blackwell芯片推迟上市的担忧可能被夸大了,预计这不会对英伟达的营收或需求产生重大影响。

英伟达CEO黄仁勋表示,Blackwell GPU的研发预算约为100 亿美元,上市后单价会在3~4万美元。鉴于当前训练和部署AI的强劲需求,该价格也并未超出市场预期。

“反英伟达”联盟

包括Alphabet、高通(172.015, 2.52, 1.49%)和英特尔(20.065, -0.07, -0.32%)在内的公司正在联手创建一个组织“UXL基金会”,旨在阻止英伟达在AI领域建立无可争议的主导地位。

UXL基金会旨在创建一个软件套件,帮助在更广泛的处理器上运行AI应用程序,并减少对英伟达平台的依赖。

据报道,UXL基金会目前正在招募微软、亚马逊和其他有影响力的科技公司。因此,尽管许多科技界的知名人士对Blackwell的能力感到兴奋,但可以理解的是,人们对更广泛的AI领域过度依赖英伟达的生态系统持抵制态度。

在某种程度上,UXL基金会的成立说明了英伟达目前的竞争地位有多强。该公司在用于AI和其他加速计算应用的GPU市场上占据了大约90%的份额,而Blackwell的推出可能有助于它继续保持甚至扩大其主导地位。

与不断扩大的专用软件工具相结合,英伟达正在重塑AI领域,而其竞争对手和潜在竞争对手还有很多工作要做。(新浪科技)

5、我们距离真正的开源人工智能还有很长的路要走

开源人工智能是过去一年最令人惊讶的科技之一。随着OpenAI和谷歌(Google)等公司投入数十亿美元打造更强大的人工智能,开发人员可以免费使用和调整的“开放”模型缩小了性能差距。

只有一个缺点:大多数开源系统都不是很开放。批评者指责他们的支持者“洗白开放”——试图从开源的光环效应中获益,因为它不受普通商业软件产品的限制,但却名不副实。

终于有动力创造一个真正开源版本的人工智能,但谁也不能保证它的进步会赶上开源软件,在过去20年里,开源软件在科技界发挥了关键作用。对于传统的开源软件,如Linux操作系统,代码是免费提供给开发人员检查、使用和调整的。所谓的开源人工智能非常不同,尤其是因为大多数现代人工智能系统从数据中学习,而不是用代码编程逻辑。

以Meta的Llama为例,只公开决定模型如何响应查询的“权重”。用户可以使用和调整它,但无法看到训练它的底层数据,也没有足够的信息从头开始复制模型。

对于许多开发人员来说,这仍然有一些明显的好处。他们可以根据自己的信息调整和训练准开放模型,而无需将敏感的内部数据交给另一家公司。

但不完全开放是有代价的。Mozilla基金会(Mozilla Foundation)高级顾问阿亚•贝迪尔(Ayah Bdeir)表示,只有真正的开源技术才能让人们全面了解那些开始影响我们生活方方面面的系统,同时还能保证创新和竞争不会被少数几家占主导地位的人工智能公司压制。

其中一个回应来自开源促进会——它在20多年前就给出了开源软件的定义。本周,它给出了一个接近最终的定义,可能有助于塑造该领域的发展方向。

这不仅需要释放模型的权重,还需要足够的关于训练模型数据的信息,以允许其他人复制模型,以及系统背后的所有代码。Mozilla和Linux基金会等其他组织也在推动类似的举措。

诸如此类的举措已经导致人工智能领域出现了更大的细分。许多公司在使用术语时更加谨慎——也许是考虑到OSI拥有“开源”一词的商标,并可能提起诉讼,以防止在其定义之外的人工智能模型上使用该术语。例如,Mistral将其Nemo称为“开放权重”模型。

除了部分开放的系统,完全开放的模型也开始出现,比如艾伦人工智能研究所开发的Olmo大型语言模型。然而,这个版本在人工智能领域是否会像在传统软件领域那样产生巨大影响,目前还远不清楚。要做到这一点,需要做两件事。

首先,这项技术需要满足足够大的需求,以吸引大量的用户和开发人员。在传统软件方面,Linux服务器操作系统显然是微软Windows的替代品,为它赢得了大量用户,并得到了包括IBM和甲骨文在内的微软竞争对手的大力支持。在人工智能领域,Linux没有对等物。市场已经变得更加分散,许多用户会发现像Llama这样的准开放大型语言模型已经足够使用。

开源人工智能的支持者还需要更好地论证其安全性。这样一种强大、通用技术的发布,任何人都可以使用,理所当然地引起了广泛的关注。

艾伦人工智能研究所前负责人奥伦·埃齐奥尼表示,许多恐惧都被夸大了。当谈到上网研究如何制造炸弹或生物武器时:“你从这些[人工智能模型]中真正能得到的并不比你从谷歌中得到的多。这些信息到处都是——只是以不同的方式打包了。”他承认,在某些领域,让人工智能更自由地使用可能会造成伤害,例如自动化创建更多的在线虚假信息。

“封闭”的人工智能也有风险。但是,除非更彻底地研究了开源技术的额外边际风险,以及潜在的好处,否则担忧仍将存在。