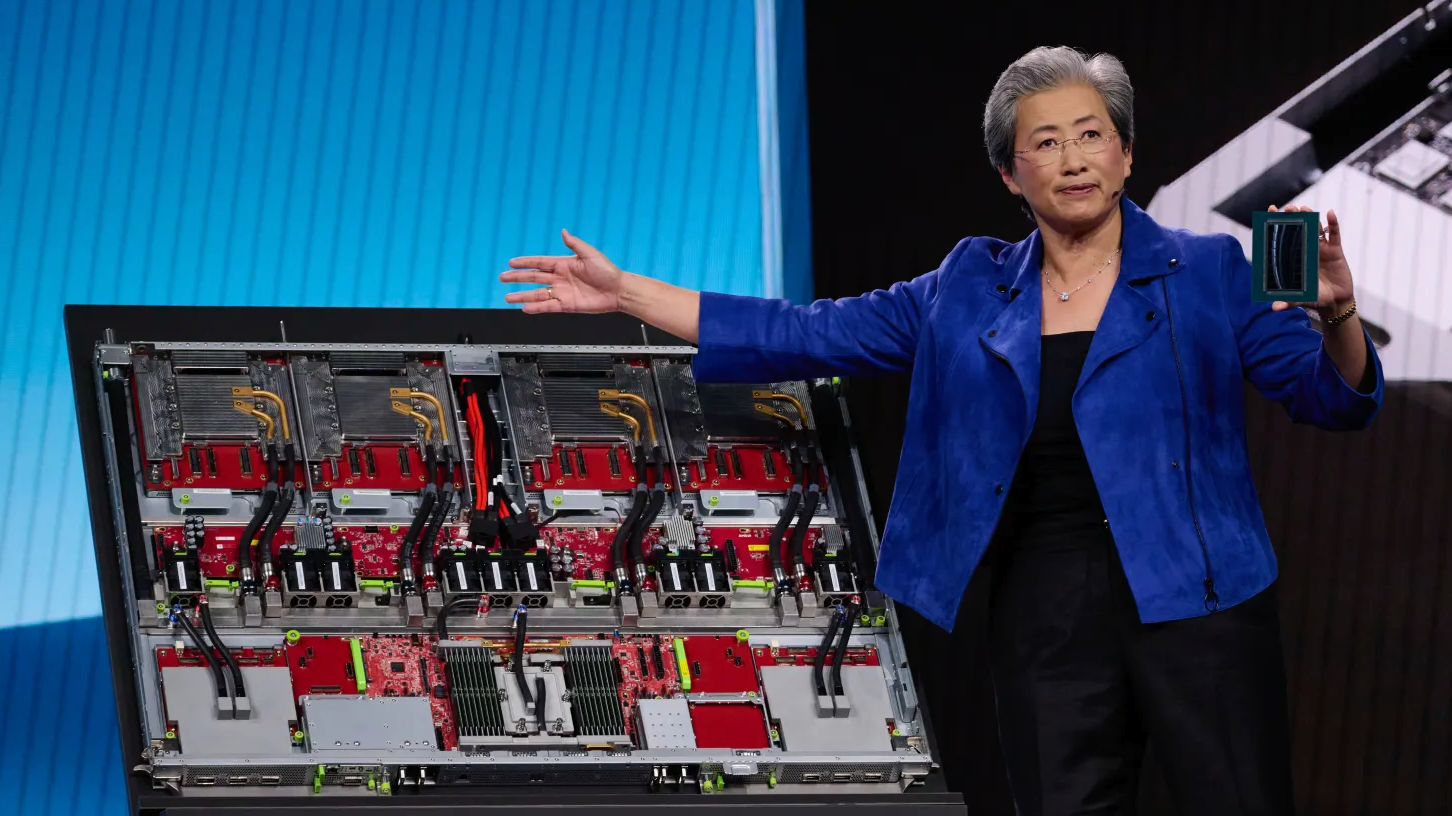

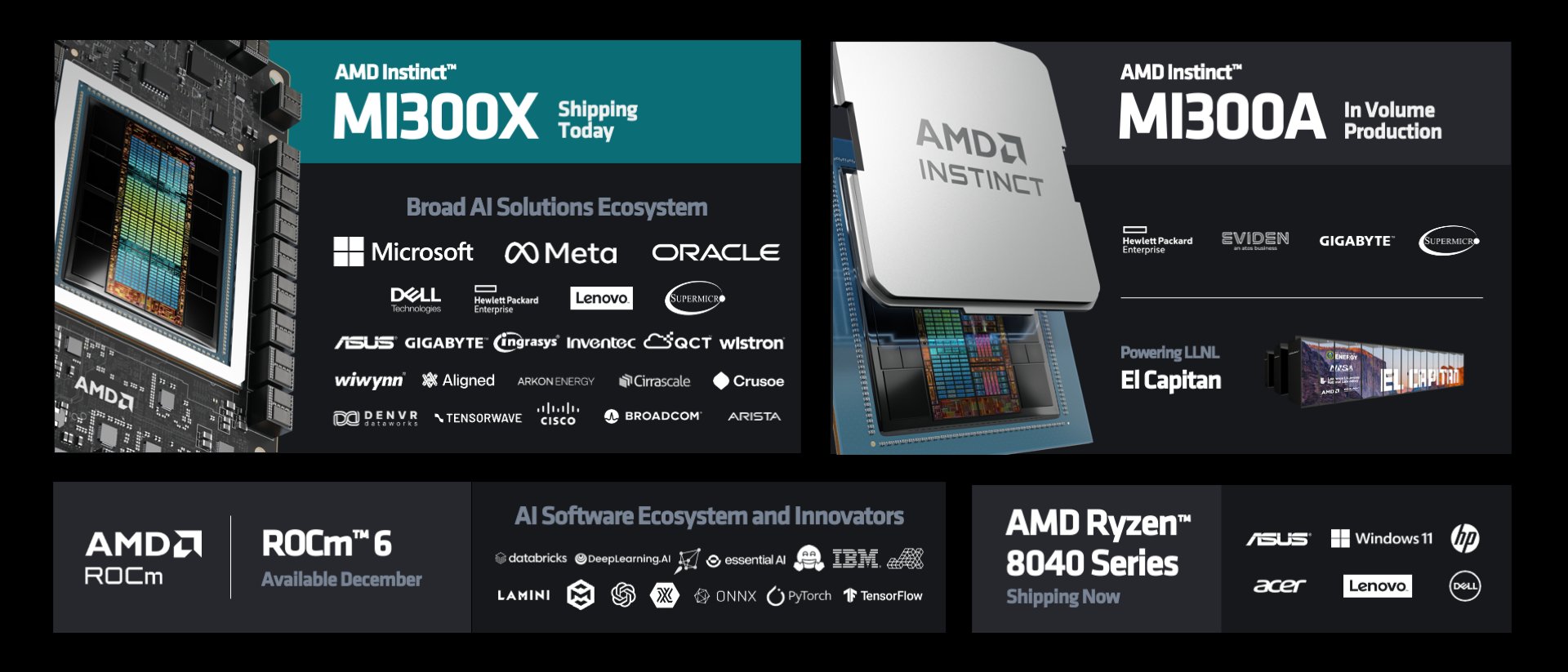

12月6日,AMD在美国加利福尼亚州举行发布会,正式发布Instinct MI300X GPU以及MI300A APU两款人工智能加速处理器。凭借全新CDNA 3架构、8颗HBM3高速内存、3.5D封装等技术,AMD的全新AI芯片部分性能、能效方面可赶超当今世界最强的英伟达H100。与此同时,AMD推出了ROCm 6 AI软件生态系统,便于客户构建生成式AI。

AMD Instinct MI300X、MI300A两款产品此前已经多次曝光,如今正式向众多OEM合作伙伴发货,价格暂未公布。

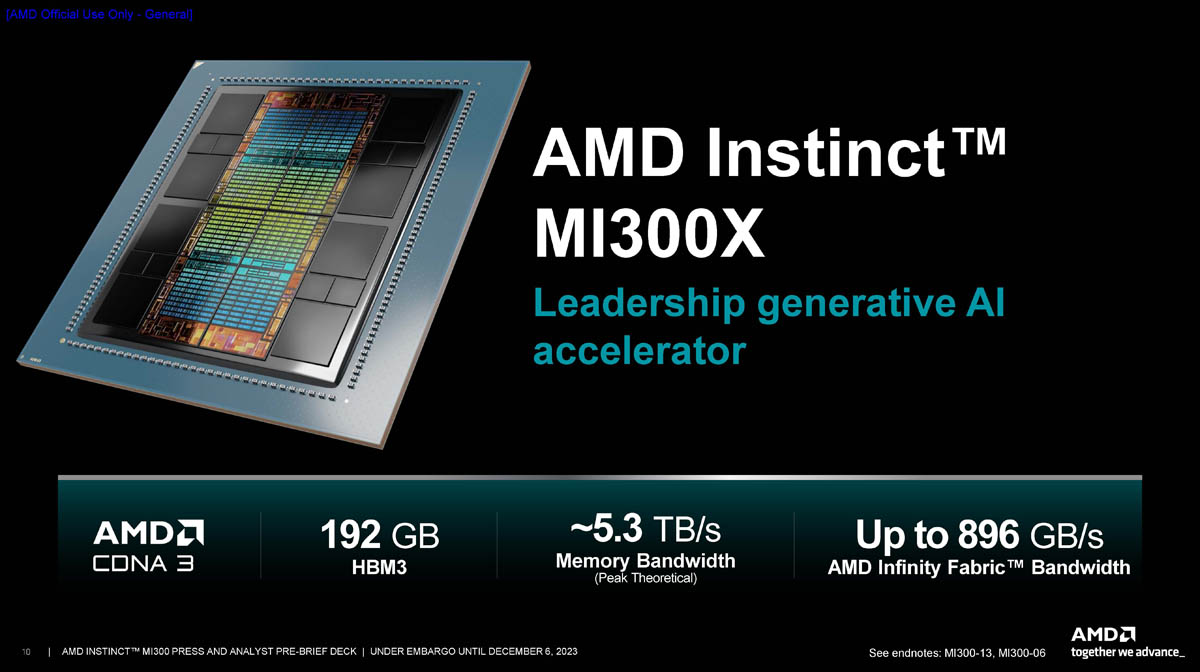

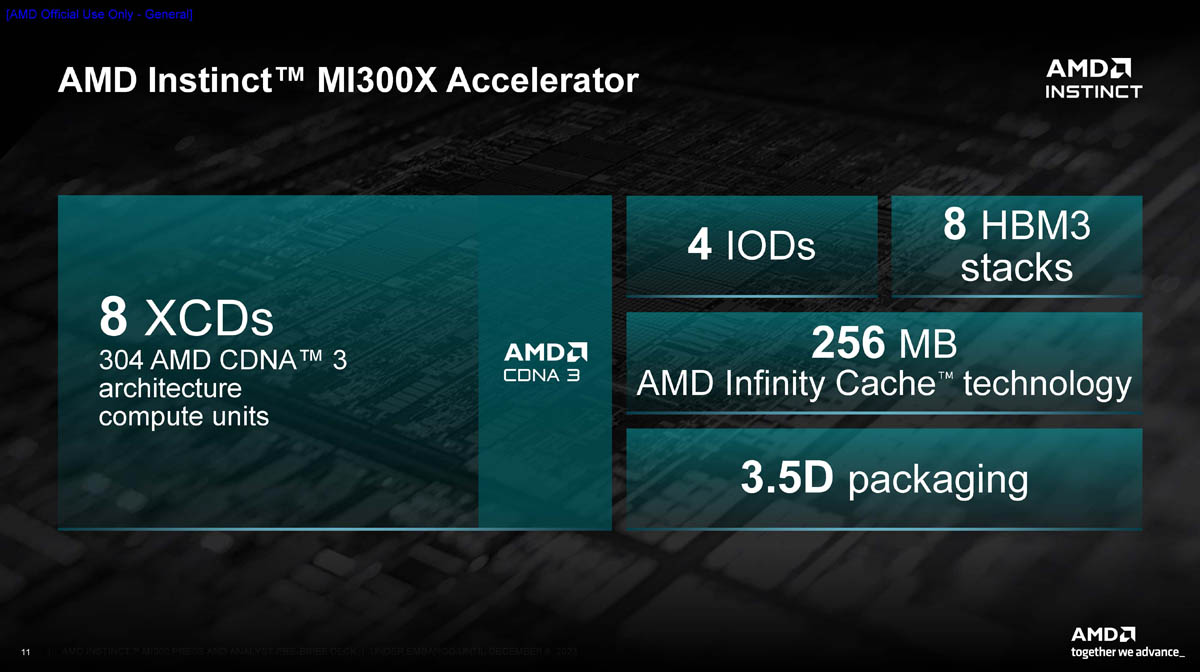

AMD Instinct MI300X

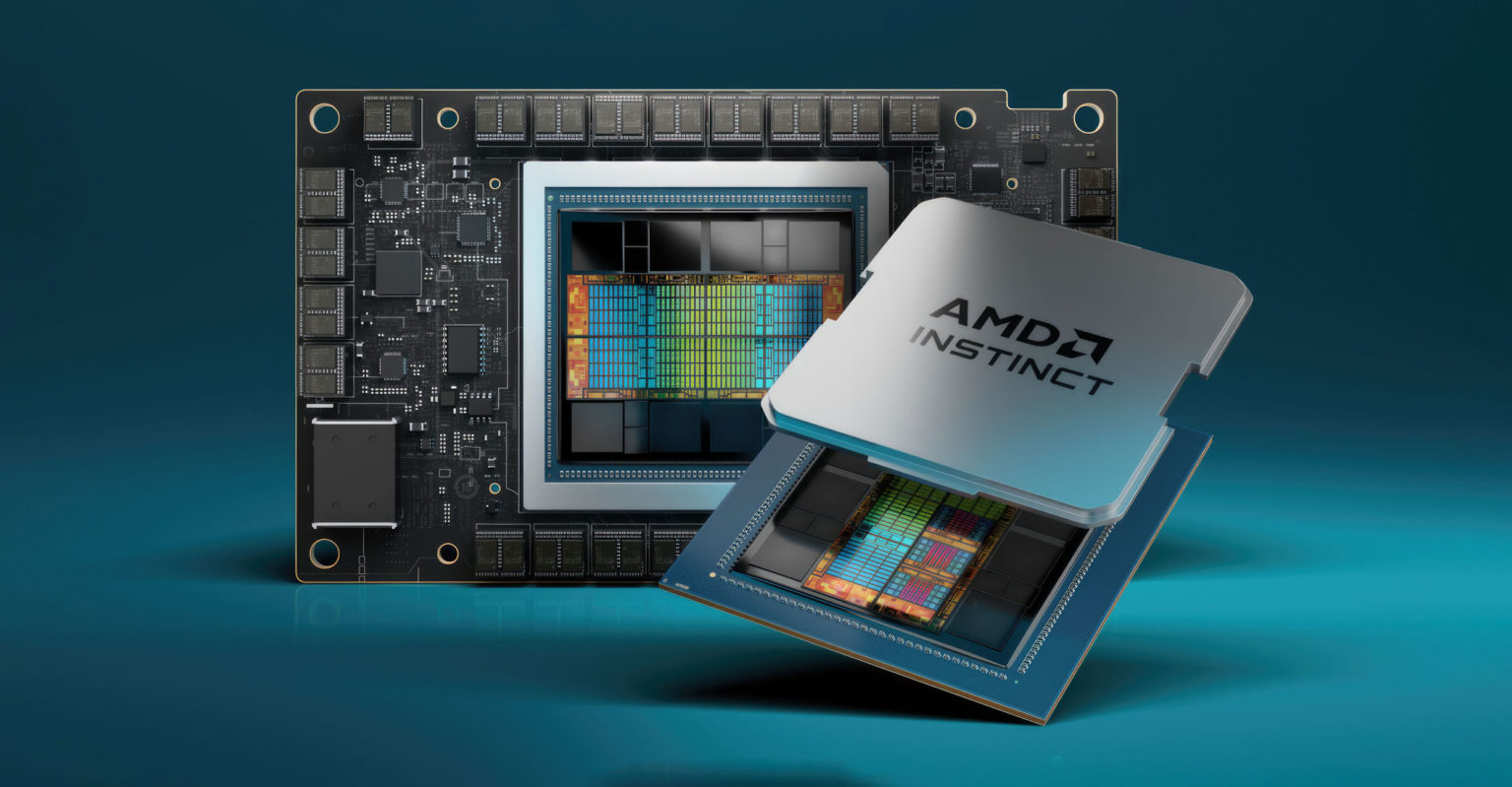

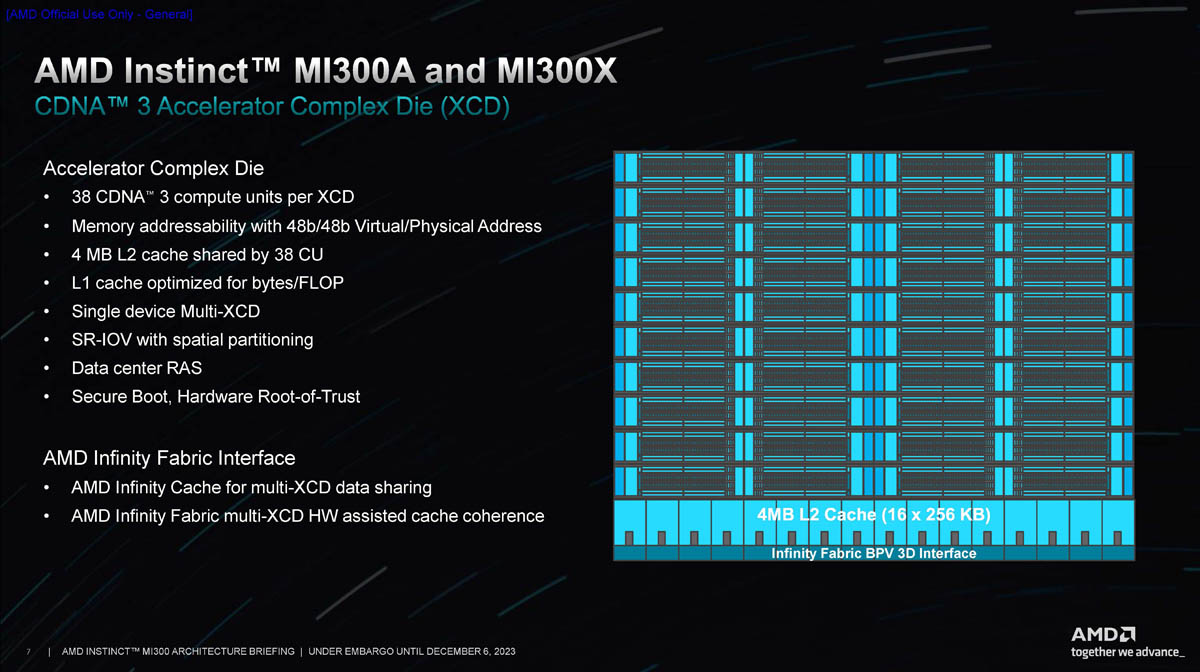

这款纯GPU加速器芯片采用全新的AMD CDNA 3架构,集成8颗5nm制程XCD GPU、8颗12层HBM3芯片、4颗6nm制程I/O单元。与上一代MI250X加速器相比,CU计算单元数量达304个,增加40%;显存容量提高至1.5倍,理论显存带宽提高至1.7倍。这款芯片集成了2.5D以及3D封装技术,AMD将其称之为“3.5D”封装。

参数方面,MI300X搭载304 CU、192GB HBM3显存、5.3TB/s带宽、256MB无限缓存(Infinity Cache)作为共享L3级高速缓存。I/O方面,提供了7×16第四代Infinity Fabric总线,处理器之间吞吐量可达896 GB/s,总功耗可达750W。

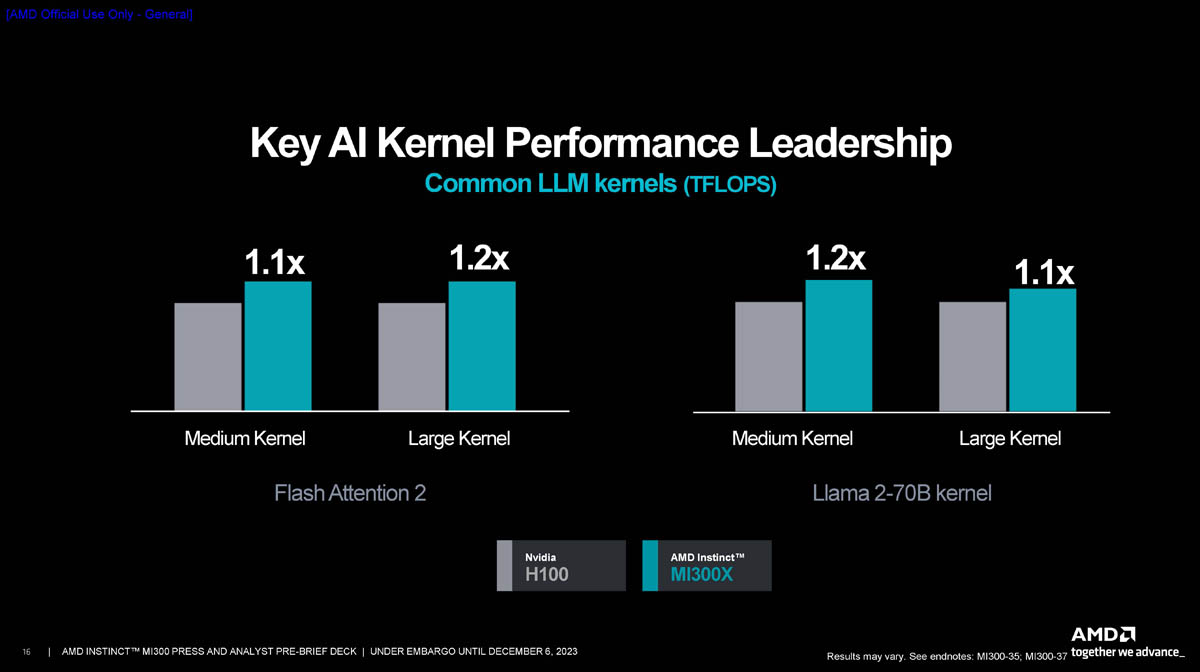

AMD表示MI300X在人工智能推理工作的性能是英伟达H100的1.6倍,在人工智能训练时的性能与H100相当,从而为业界提供了替代选项,以取代英伟达GPU。得益于高达192GB(是H100 80GB的两倍多)的高速HBM3显存,MI300X平台能够支持更大规模的大语言模型(LLM)。

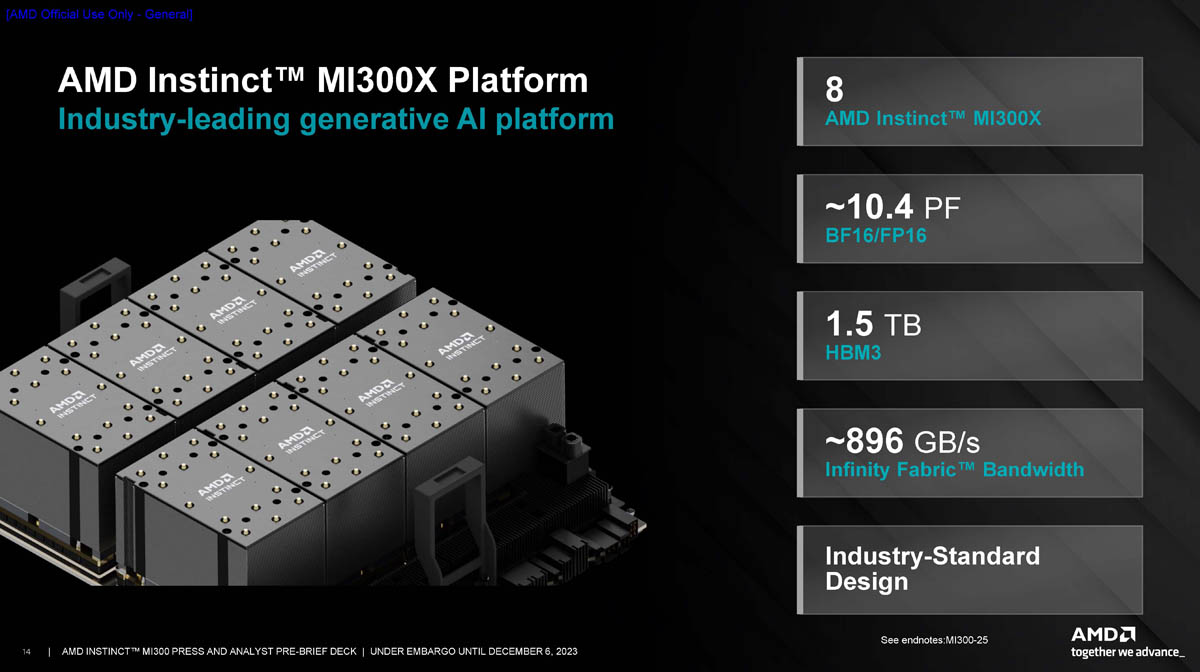

性能方面,AMD使用同样由8颗GPU组成的MI300X、H100 HGX计算平台进行对比,前者可提供高达1.5TB的HBM3存储容量,峰值性能10.4 PFlops(BF16/FP16),比H100平台提高了1.3倍。在运行Bloom 1760亿参数大语言模型时,MI300X性能是H100的1.6倍;700亿参数Liama 2大模型性能达到了1.4倍,此外在多种通用LLM模型的表现均超过H100平台。在进行MPT 300亿参数模型训练时,MI300X平台的表现与H100几乎一致。以下为详细对比:

其它方面,AMD为MI300X平台配备了400G高速网络连接,支持多种网卡;系统基于开放计算项目(OCP)和通用底板(UBB)设计标准构建,从而简化了超大规模服务器集群的建设过程。

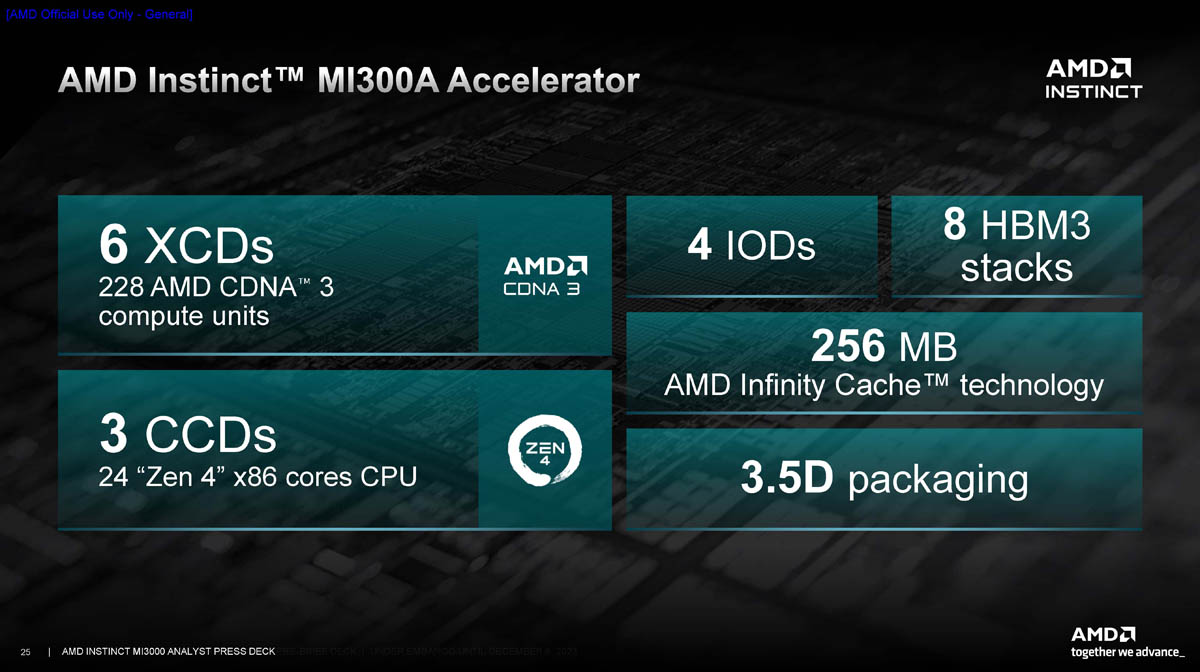

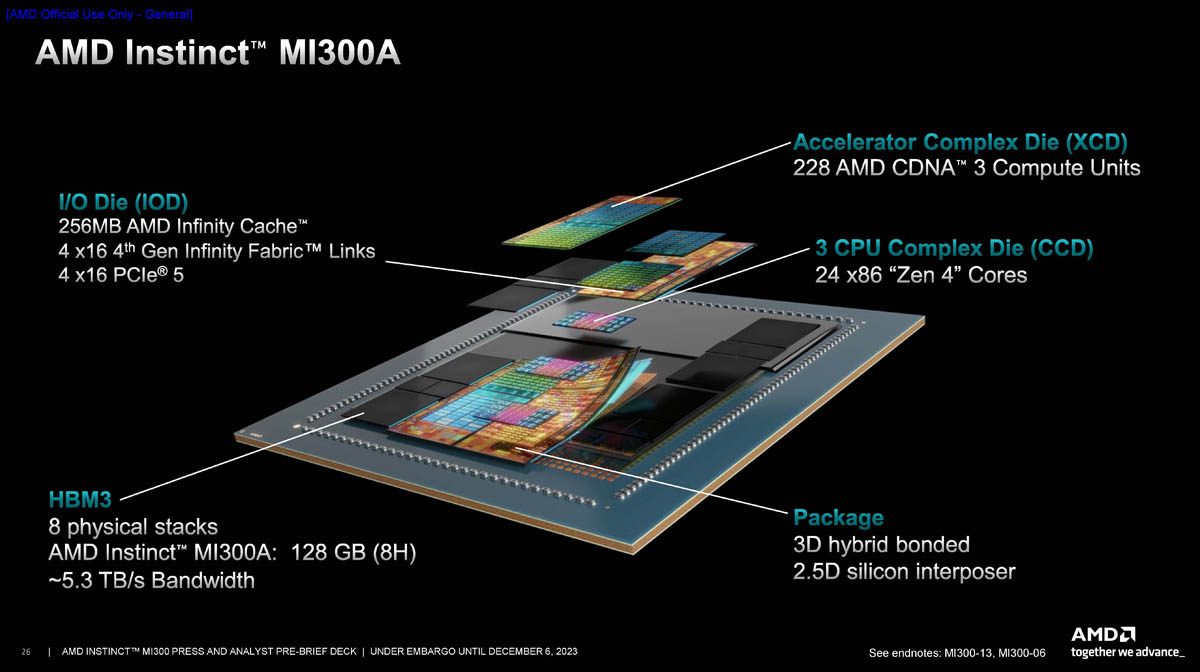

AMD Instinct MI300A

这款产品属于APU,集成6颗CDNA 3架构GPU XCD单元、3颗Zen4架构CPU CCD单元、8颗8层HBM3芯片、4颗I/O单元,同样采用3.5D封装技术。该芯片拥有228 CU GPU、24核CPU,共计128GB HBM3存储,256MB无限缓存(Infinity Cache)。HBM带宽同样为5.3TB/s。

I/O连接性能方面,MI300A同时拥有4×16第四代Infinity Fabric总线、4×16 PCIe 5通道。

MI300A的默认TDP为350W,但最高可配置为760W,支持在CPU、GPU之间动态分配功率,从而优化性能和效率。该产品与EPYC Genoa处理器一样,采用AMD标准的LGA6096插座,但是在电气方面与EPYC处理器并不兼容。

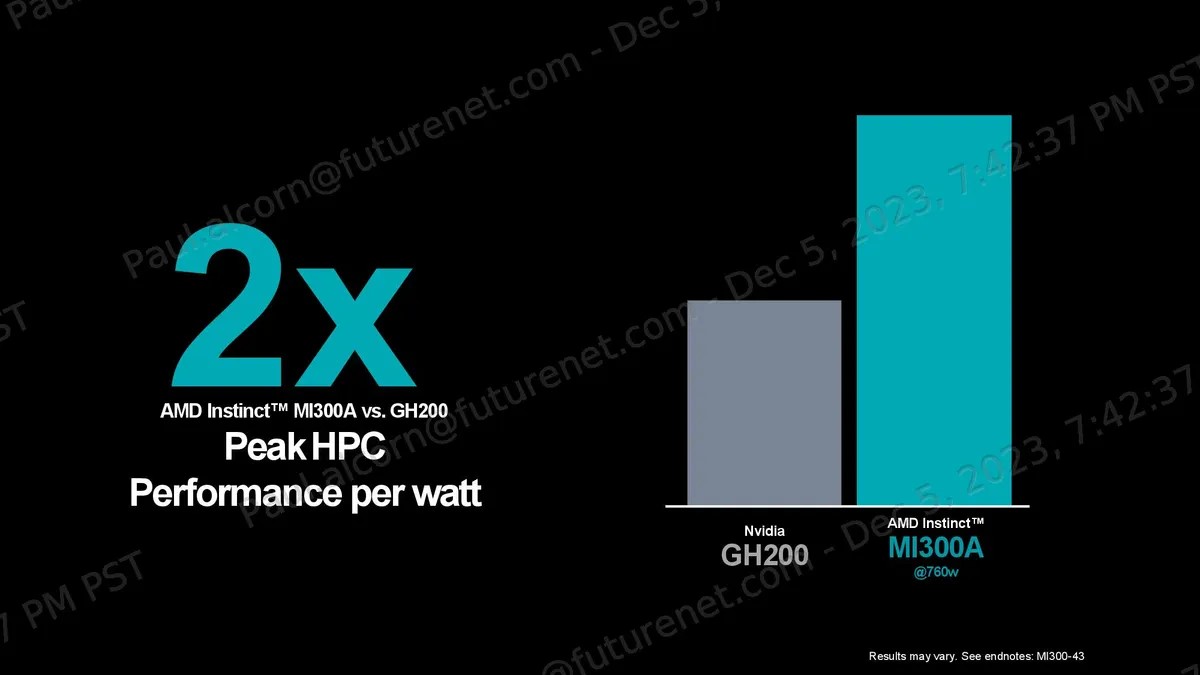

AMD表示,MI300A是世界首款专用于HPC和AI的数据中心APU,用途广泛,能效是上一代MI250X的1.9倍。能源效率是HPC与AI应用最关注的指标,然而当前数据中心的耗能非常高,属资源密集型产业。AMD Instinct MI300A APU得益于同时封装CPU与GPU计算单元,提供了高效性能,便于训练最新的AI大模型。目前AMD正在进行创新,以实现该公司能效30×25目标,希望将服务器处理器、AI加速器的能效在2020~2025年期间提升30倍。

性能方面,MI300A平台OpenFOAM测试成绩是英伟达H100的四倍,与GH200超级芯片相比,每瓦性能也达到了2倍,在运行多种跑分测试时均小幅超过H100平台。

AMD ROCm软件和生态系统

AMD当日同时推出了最新的AMD ROCm 6开源软件平台,作为对开源生态的承诺。这款软件结合MI300系列处理器,可帮助Liama 2大语言模型计算提速8倍。此外,ROCm 6系列软件还提供了众多新特性,包括FlashAttention、HIPGraph、vLLM等。软件生态同样支持多种被广泛使用的开源AI软件模型、框架,为生成式AI释放潜力。

集微网获悉,戴尔、HPE慧与、联想、Meta、微软、甲骨文、超微以及其它AMD的合作伙伴,即日起都将采用英伟达MI300系列产品,构建AI数据中心解决方案。

(校对/张杰)